Training Generative Adversarial Networks with Limited Data

Abstract

Training generative adversarial networks (GAN) using too little data typically leads to discriminator overfitting, causing training to diverge.

We propose an adaptive discriminator augmentation mechanism that significantly stabilizes training in limited data regimes.

The approach does not require changes to loss functions or network architectures, and is applicable both when training from scratch and when fine-tuning an existing GAN on another dataset.

We demonstrate, on several datasets, that good results are now possible using only a few thousand training images, often matching StyleGAN2 results with an order of magnitude fewer images.

We expect this to open up new application domains for GANs.

We also find that the widely used CIFAR-10 is, in fact, a limited data benchmark, and improve the record FID from 5.59 to 2.42.

너무 적은 데이터를 사용하여 GAN (Generative Adversarial Network)을 훈련하면 일반적으로 판별자가 과적 합되어 훈련이 분산됩니다. 제한된 데이터 영역에서 훈련을 상당히 안정화시키는 적응 형 판별 자 증강 메커니즘을 제안합니다. 이 접근 방식은 손실 기능이나 네트워크 아키텍처를 변경할 필요가 없으며 처음부터 훈련 할 때와 다른 데이터 세트에서 기존 GAN을 미세 조정할 때 모두 적용 할 수 있습니다. 우리는 여러 데이터 세트에서 이제 수천 개의 학습 이미지만으로도 좋은 결과를 얻을 수 있으며 종종 StyleGAN2 결과를 수십 배 더 적은 이미지와 일치시킵니다. 우리는 이것이 GAN을위한 새로운 애플리케이션 도메인을 열 것으로 기대합니다. 또한 널리 사용되는 CIFAR-10은 실제로 제한된 데이터 벤치 마크이며 레코드 FID를 5.59에서 2.42로 개선했습니다.

1 Introduction

The increasingly impressive results of generative adversarial networks (GAN) [14, 32, 31, 5, 19, 20, 21] are fueled by the seemingly unlimited supply of images available online.

Still, it remains challenging to collect a large enough set of images for a specific application that places constraints on subject type, image quality, geographical location, time period, privacy, copyright status, etc.

The difficulties are further exacerbated in applications that require the capture of a new, custom dataset: acquiring, processing, and distributing the ∼ 105 − 106 images required to train a modern high-quality, high-resolution GAN is a costly undertaking.

This curbs the increasing use of generative models in fields such as medicine [47].

A significant reduction in the number of images required therefore has the potential to considerably help many applications.

GAN (Generative Adversarial Network) [14, 32, 31, 5, 19, 20, 21]의 인상적인 결과는 온라인에서 사용할 수있는 이미지의 무제한 공급에 의해 촉진됩니다. 그럼에도 불구하고 주제 유형, 이미지 품질, 지리적 위치, 기간, 개인 정보 보호, 저작권 상태 등에 제약을 두는 특정 애플리케이션에 대해 충분히 큰 이미지 세트를 수집하는 것은 여전히 어렵습니다. 새로운 맞춤형 데이터 세트를 캡처해야하는 애플리케이션에서는 어려움이 더욱 악화됩니다. 현대의 고품질 고해상도 GAN을 훈련하는 데 필요한 ~ 105 ~ 106 개의 이미지를 수집, 처리 및 배포하는 것은 비용이 많이 드는 작업입니다. 이것은 의학과 같은 분야에서 생성 모델의 사용 증가를 억제합니다 [47]. 따라서 필요한 이미지 수를 크게 줄이면 많은 응용 프로그램에 상당한 도움이 될 수 있습니다.

The key problem with small datasets is that the discriminator overfits to the training examples; its feedback to the generator becomes meaningless and training starts to diverge [2, 48].

In almost all areas of deep learning [40], dataset augmentation is the standard solution against overfitting.

For example, training an image classifier under rotation, noise, etc., leads to increasing invariance to these semantics-preserving distortions — a highly desirable quality in a classifier [17, 8, 9].

In contrast, a GAN trained under similar dataset augmentations learns to generate the augmented distribution [50, 53].

In general, such “leaking” of augmentations to the generated samples is highly undesirable.

For example, a noise augmentation leads to noisy results, even if there is none in the dataset.

작은 데이터 세트의 핵심 문제는 판별자가 훈련 예제에 과적 합한다는 것입니다. 발전기에 대한 피드백은 의미가 없어지고 훈련이 분산되기 시작합니다 [2, 48]. 거의 모든 딥 러닝 영역에서 [40] 데이터 세트 확대는 과적 합에 대한 표준 솔루션입니다. 예를 들어, 회전, 노이즈 등에서 이미지 분류기를 훈련하면 이러한 의미 체계에 대한 불변성이 증가하여 왜곡을 보존합니다. 이는 분류기에서 매우 바람직한 품질입니다 [17, 8, 9]. 대조적으로, 유사한 데이터 세트 증가 하에서 훈련 된 GAN은 증가 된 분포를 생성하는 방법을 학습합니다 [50, 53]. 일반적으로, 생성 된 샘플에 대한 이러한 증가의 "누출"은 매우 바람직하지 않습니다. 예를 들어, 노이즈 증가는 데이터 세트에 아무것도 없더라도 노이즈가 많은 결과를 초래합니다.

In this paper, we demonstrate how to use a wide range of augmentations to prevent the discriminator from overfitting, while ensuring that none of the augmentations leak to the generated images.

We start by presenting a comprehensive analysis of the conditions that prevent the augmentations from leaking.

We then design a diverse set of augmentations, and an adaptive control scheme that enables the same approach to be used regardless of the amount of training data, properties of the dataset, or the exact training setup (e.g., training from scratch or transfer learning [33, 44, 45, 34]).

We demonstrate, on several datasets, that good results are now possible using only a few thousand images, often matching StyleGAN2 results with an order of magnitude fewer images.

Furthermore, we show that the popular CIFAR-10 benchmark suffers from limited data and achieve a new record Fréchet inception distance (FID) [18] of 2.42, significantly improving over the current state of the art of 5.59 [52].

We also present METFACES, a high-quality benchmark dataset for limited data scenarios.

Our implementation and models are available at https://github.com/NVlabs/stylegan2-ada

이 백서에서는 판별자가 과적 합되는 것을 방지하는 동시에 생성 된 이미지에 어떤 증강도 누출되지 않도록하기 위해 광범위한 증강을 사용하는 방법을 보여줍니다. 증강이 누출되는 것을 방지하는 조건에 대한 포괄적 인 분석을 제시하는 것으로 시작합니다. 그런 다음 학습 데이터의 양, 데이터 세트의 속성 또는 정확한 학습 설정 (예 : 처음부터 학습 또는 전이 학습 [])에 관계없이 동일한 접근 방식을 사용할 수 있도록 다양한 증강 세트와 적응 형 제어 체계를 설계합니다. 33, 44, 45, 34]). 우리는 여러 데이터 세트에서 이제 수천 개의 이미지만으로도 좋은 결과를 얻을 수 있음을 보여 주며, 종종 StyleGAN2 결과와 훨씬 더 적은 이미지를 일치시킵니다. 또한 인기있는 CIFAR-10 벤치 마크가 제한된 데이터로 인해 어려움을 겪고 있으며 2.42의 새로운 기록 Fréchet 개시 거리 (FID) [18]를 달성하여 현재의 5.59 [52] 기술에 비해 크게 향상되었습니다. 또한 제한된 데이터 시나리오를위한 고품질 벤치 마크 데이터 세트 인 METFACES를 제공합니다. 구현 및 모델은 https://github.com/NVlabs/stylegan2-ada에서 사용할 수 있습니다.

2 Overfitting in GANs

We start by studying how the quantity of available training data affects GAN training.

We approach this by artificially subsetting larger datasets (FFHQ and LSUN CAT) and observing the resulting dynamics.

For our baseline, we considered StyleGAN2 [21] and BigGAN [5, 38].

Based on initial testing, we settled on StyleGAN2 because it provided more predictable results with significantly lower variance between training runs (see Appendix A).

For each run, we randomize the subset of training data, order of training samples, and network initialization.

To facilitate extensive sweeps over dataset sizes and hyperparameters, we use a downscaled 256 × 256 version of FFHQ and a lighter-weight configuration that reaches the same quality as the official StyleGAN2 config F for this dataset, but runs 4.6× faster on NVIDIA DGX-1.1

We measure quality by computing FID between 50k generated images and all available training images, as recommended by Heusel et al. [18], regardless of the subset actually used for training.

사용 가능한 훈련 데이터의 양이 GAN 훈련에 어떤 영향을 미치는지 연구하는 것으로 시작합니다. 우리는 더 큰 데이터 세트 (FFHQ 및 LSUN CAT)를 인위적으로 부분 집합 화하고 결과 역학을 관찰하여 이에 접근합니다. 기준선으로는 StyleGAN2 [21] 및 BigGAN [5, 38]을 고려했습니다. 초기 테스트를 기반으로 우리는 StyleGAN2가 훈련 실행 간의 차이가 현저히 낮 으면서 더 예측 가능한 결과를 제공했기 때문에 결정했습니다 (부록 A 참조). 각 실행에 대해 훈련 데이터의 하위 집합, 훈련 샘플 순서 및 네트워크 초기화를 무작위 화합니다. 데이터 세트 크기와 하이퍼 파라미터에 대한 광범위한 스윕을 용이하게하기 위해 축소 된 256 × 256 버전의 FFHQ와이 데이터 세트의 공식 StyleGAN2 구성 F와 동일한 품질에 도달하는 더 가벼운 구성을 사용하지만 NVIDIA DGX-에서는 4.6 배 더 빠르게 실행됩니다. 1.1 Heusel 등이 권장하는대로 50k 생성 이미지와 사용 가능한 모든 교육 이미지 사이의 FID를 계산하여 품질을 측정합니다. [18], 실제로 훈련에 사용되는 부분 집합에 관계없이.

Figure 1a shows our baseline results for different subsets of FFHQ.

Training starts the same way in each case, but eventually the progress stops and FID starts to rise.

The less training data there is, the earlier this happens. Figure 1b,c shows the discriminator output distributions for real and generated images during training.

The distributions overlap initially but keep drifting apart as the discriminator becomes more and more confident, and the point where FID starts to deteriorate is consistent with the loss of sufficient overlap between distributions.

This is a strong indication of overfitting, evidenced further by the drop in accuracy measured for a separate validation set.

We propose a way to tackle this problem by employing versatile augmentations that prevent the discriminator from becoming overly confident.

그림 1a는 FFHQ의 다양한 하위 집합에 대한 기준 결과를 보여줍니다. 훈련은 각 경우에 동일한 방식으로 시작되지만 결국 진행이 중지되고 FID가 상승하기 시작합니다. 훈련 데이터가 적을수록 더 빨리 발생합니다. 그림 1b, c는 훈련 중 실제 이미지와 생성 된 이미지에 대한 판별 기 출력 분포를 보여줍니다. 분포는 처음에는 겹치지 만 판별자가 점점 더 확실 해짐에 따라 계속 떨어져 표류하고 FID가 악화되기 시작하는 지점은 분포 간의 충분한 중복 손실과 일치합니다. 이는 별도의 검증 세트에 대해 측정 된 정확도의 저하로 더욱 입증되는 과적 합의 강력한 표시입니다. 우리는 차별자가 지나치게 자신감이 생기는 것을 방지하는 다목적 증강을 사용하여이 문제를 해결하는 방법을 제안합니다.

2.1 Stochastic discriminator augmentation

By definition, any augmentation that is applied to the training dataset will get inherited to the generated images [14].

Zhao et al. [53] recently proposed balanced consistency regularization (bCR) as a solution that is not supposed to leak augmentations to the generated images.

Consistency regularization states that two sets of augmentations, applied to the same input image, should yield the same output [35, 27].

Zhao et al. add consistency regularization terms for the discriminator loss, and enforce discriminator consistency for both real and generated images, whereas no augmentations or consistency loss terms are applied when training the generator (Figure 2a). As such, their approach effectively strives to generalize the discriminator by making it blind to the augmentations used in the CR term.

However, meeting this goal opens the door for leaking augmentations, because the generator will be free to produce images containing them without any penalty.

In Section 4, we show experimentally that bCR indeed suffers from this problem, and thus its effects are fundamentally similar to dataset augmentation.

정의에 따라 훈련 데이터 세트에 적용되는 모든 증강은 생성 된 이미지에 상속됩니다 [14]. Zhao et al. 최근에 생성 된 이미지에 증가를 유출하지 않는 솔루션으로 균형 잡힌 일관성 정규화 (bCR)를 제안했습니다. 일관성 정규화는 동일한 입력 이미지에 적용된 두 세트의 증가가 동일한 출력을 산출해야한다고 말합니다 [35, 27]. Zhao et al. 판별 자 손실에 대한 일관성 정규화 용어를 추가하고 실제 이미지와 생성 된 이미지 모두에 대해 판별 자 일관성을 적용하는 반면, 생성기를 훈련 할 때는 증가 또는 일관성 손실 용어가 적용되지 않습니다 (그림 2a). 따라서, 그들의 접근 방식은 CR 용어에 사용되는 증강을 알지 못하도록 판별자를 일반화하는 데 효과적으로 노력합니다. 그러나이 목표를 달성하면 생성기가 페널티없이 확장을 포함하는 이미지를 자유롭게 생성 할 수 있기 때문에 확장이 누출 될 수 있습니다. 섹션 4에서 우리는 bCR이 실제로이 문제를 겪고 있다는 것을 실험적으로 보여 주므로 그 효과는 근본적으로 데이터 세트 증가와 유사합니다.

Our solution is similar to bCR in that we also apply a set of augmentations to all images shown to the discriminator.

However, instead of adding separate CR loss terms, we evaluate the discriminator only using augmented images, and do this also when training the generator (Figure 2b).

This approach that we call stochastic discriminator augmentation is therefore very straightforward.

Yet, this possibility has received little attention, possibly because at first glance it is not obvious if it even works:

if the discriminator never sees what the training images really look like, it is not clear if it can guide the generator properly (Figure 2c).

We will therefore first investigate the conditions under which this approach will not leak an augmentation to the generated images, and then build a full pipeline out of such transformations.

우리의 솔루션은 식별기에 표시되는 모든 이미지에 일련의 증강을 적용한다는 점에서 bCR과 유사합니다. 그러나 별도의 CR 손실 항을 추가하는 대신 증강 이미지 만 사용하여 판별자를 평가하고 생성기를 훈련 할 때도이를 수행합니다 (그림 2b). 따라서 확률 적 판별 자 증가라고하는이 접근 방식은 매우 간단합니다. 그러나이 가능성은 거의 주목을받지 못했습니다. 아마도 언뜻보기에 그것이 작동하는지 확실하지 않기 때문일 것입니다. 판별자가 훈련 이미지가 실제로 어떻게 보이는지 전혀 알지 못하는 경우 생성기를 올바르게 안내 할 수 있는지 여부가 명확하지 않습니다 (그림 2c). 따라서 먼저이 접근 방식이 생성 된 이미지에 대한 증가를 유출하지 않는 조건을 조사한 다음 이러한 변환에서 전체 파이프 라인을 구축합니다.

2.2 Designing augmentations that do not leak 누출되지 않는 증강 설계

Discriminator augmentation corresponds to putting distorting, perhaps even destructive goggles on the discriminator, and asking the generator to produce samples that cannot be distinguished from the training set when viewed through the goggles.

Bora et al. [4] consider a similar problem in training GANs under corrupted measurements, and show that the training implicitly undoes the corruptions and finds the correct distribution, as long as the corruption process is represented by an invertible transformation of probability distributions over the data space.

We call such augmentation operators non-leaking.

판별 자 증강은 판별 자에 왜곡 된 고글 (아마도 파괴적인 고글까지)을 놓고 고글을 통해 볼 때 훈련 세트와 구별 할 수없는 샘플을 생성하도록 요청하는 것과 같습니다.

Bora et al. [4] 손상된 측정에서 GAN을 훈련 할 때 유사한 문제를 고려하고, 손상 과정이 데이터 공간에 대한 확률 분포의 역변환으로 표현되는 한, 훈련이 암시 적으로 손상을 취소하고 올바른 분포를 찾는다는 것을 보여줍니다.

The power of these invertible transformations is that they allow conclusions about the equality or inequality of the underlying sets to be drawn by observing only the augmented sets.

It is crucial to understand that this does not mean that augmentations performed on individual images would need to be undoable. For instance, an augmentation as extreme as setting the input image to zero 90% of the time is invertible in the probability distribution sense: it would be easy, even for a human, to reason about the original distribution by ignoring black images until only 10% of the images remain.

On the other hand, random rotations chosen uniformly from {0◦, 90◦, 180◦, 270◦} are not invertible:

it is impossible to discern differences among the orientations after the augmentation.

이러한 역변환의 힘은 증강 된 집합 만 관찰하여 기본 집합의 동등성 또는 부등성에 대한 결론을 도출 할 수 있다는 것입니다. 이것이 개별 이미지에 대해 수행 된 증강을 취소 할 수 있어야한다는 것을 의미하지는 않는다는 것을 이해하는 것이 중요합니다. 예를 들어, 입력 이미지를 0으로 설정하는 것과 같은 극단적 인 확대는 확률 분포의 의미에서 반전 할 수 있습니다. 인간도 10 개까지만 검은 색 이미지를 무시하여 원래 분포를 추론하는 것이 쉽습니다. 이미지의 %가 남아 있습니다. 반면에 {0◦, 90◦, 180◦, 270◦}에서 균일하게 선택한 임의 회전은 반전 할 수 없습니다. 확대 후 방향 간의 차이를 식별하는 것은 불가능합니다.

The situation changes if this rotation is only executed at a probability p < 1: this increases the relative occurrence of 0◦, and now the augmented distributions can match only if the generated images have correct orientation.

Similarly, many other stochastic augmentations can be designed to be non-leaking on the condition that they are skipped with a non-zero probability.

Appendix C shows that this can be made to hold for a large class of widely used augmentations, including deterministic mappings (e.g., basis transformations), additive noise, transformation groups (e.g, image or color space rotations, flips and scaling), and projections (e.g., cutout [11]).

Furthermore, composing non-leaking augmentations in a fixed order yields an overall non-leaking augmentation.

이 회전이 확률 p <1에서만 실행되는 경우 상황이 변경됩니다. 이는 0◦의 상대적 발생을 증가시키고 이제 생성 된 이미지의 방향이 올바른 경우에만 증가 된 분포가 일치 할 수 있습니다. 유사하게, 많은 다른 확률 적 증가는 0이 아닌 확률로 건너 뛰는 조건에서 누출되지 않도록 설계 될 수 있습니다. 부록 C는 이것이 결정 론적 매핑 (예 : 기본 변환), 추가 노이즈, 변환 그룹 (예 : 이미지 또는 색 공간 회전, 뒤집기 및 크기 조정) 및 투영을 포함하여 널리 사용되는 많은 종류의 증강에 적용 할 수 있음을 보여줍니다. (예 : 컷 아웃 [11]). 또한, 고정 된 순서로 비누 출 증가를 구성하면 전체 비누 출 증가가 생성됩니다.

In Figure 3 we validate our analysis by three practical examples. Isotropic scaling with log-normal distribution is an example of an inherently safe augmentation that does not leak regardless of the value of p (Figure 3a).

However, the aforementioned rotation by a random multiple of 90◦ must be skipped at least part of the time (Figure 3b).

When p is too high, the generator cannot know which way the generated images should face and ends up picking one of the possibilities at random.

As could be expected, the problem does not occur exclusively in the limiting case of p = 1.

In practice, the training setup is poorly conditioned for nearby values as well due to finite sampling, finite representational power of the networks, inductive bias, and training dynamics.

When p remains below ∼0.85, the generated images are always oriented correctly. Between these regions, the generator sometimes picks a wrong orientation initially, and then partially drifts towards the correct distribution.

The same observations hold for a sequence of continuous color augmentations (Figure 3c).

This experiment suggests that as long as p remains below 0.8, leaks are unlikely to happen in practice.

그림 3에서는 세 가지 실제 사례를 통해 분석을 검증합니다. 로그 정규 분포를 사용한 등방성 스케일링은 p 값에 관계없이 누출되지 않는 본질적으로 안전한 증가의 예입니다 (그림 3a). 그러나 위에서 언급 한 90o의 임의 배수에 의한 회전은 적어도 시간의 일부를 건너 뛰어야합니다 (그림 3b). p가 너무 높으면 생성기는 생성 된 이미지가 어떤 방향을 향해야하는지 알 수 없어 무작위로 가능성 중 하나를 선택하게됩니다. 예상 할 수 있듯이 p = 1 인 경우에만 문제가 발생하지 않습니다. 실제로, 훈련 설정은 유한 샘플링, 네트워크의 유한 표현력, 유도 편향 및 훈련 역학으로 인해 인근 값에 대해 열악한 조건을 갖습니다. p가 ∼0.85 미만으로 유지되면 생성 된 이미지는 항상 올바른 방향입니다. 이러한 영역 사이에서 생성기는 처음에 잘못된 방향을 선택한 다음 부분적으로 올바른 분포로 이동합니다. 연속적인 색상 증가에 대해서도 동일한 관찰이 유지됩니다 (그림 3c). 이 실험은 p가 0.8 미만으로 유지되는 한 실제로 누출이 발생하지 않을 것임을 시사합니다.

2.3 Our augmentation pipeline 증강 파이프 라인

We start from the assumption that a maximally diverse set of augmentations is beneficial, given the success of RandAugment [9] in image classification tasks. We consider a pipeline of 18 transformations that are grouped into 6 categories: pixel blitting (x-flips, 90◦rotations, integer translation), more general geometric transformations, color transforms, image-space filtering, additive noise [41], and cutout [11].

Details of the individual augmentations are given in Appendix B.

Note that we execute augmentations also when training the generator (Figure 2b), which requires the augmentations to be differentiable.

We achieve this by implementing them using standard differentiable primitives offered by the deep learning framework.

이미지 분류 작업에서 RandAugment [9]의 성공을 고려할 때 최대한 다양한 증강 세트가 유익하다는 가정에서 시작합니다. 픽셀 블리 팅 (x-flips, 90o 회전, 정수 변환),보다 일반적인 기하학적 변환, 색상 변환, 이미지 공간 필터링, 추가 노이즈 [41], 컷 아웃 등 6 개 범주로 그룹화 된 18 개의 변환 파이프 라인을 고려합니다. [11].

개별 확장에 대한 자세한 내용은 부록 B에 나와 있습니다. 생성기를 훈련 할 때도 증강을 실행하므로 (그림 2b), 증강을 차별화 할 수 있어야합니다. 우리는 딥 러닝 프레임 워크에서 제공하는 차별화 가능한 표준 프리미티브를 사용하여이를 구현합니다.

During training, we process each image shown to the discriminator using a pre-defined set of transformations in a fixed order.

The strength of augmentations is controlled by the scalar p ∈ [0, 1],so that each transformation is applied with probability p or skipped with probability 1 − p.

We always use the same value of p for all transformations.

The randomization is done separately for each augmentation and for each image in a minibatch.

Given that there are many augmentations in the pipeline, even fairly small values of p make it very unlikely that the discriminator sees a clean image (Figure 2c).

Nonetheless, the generator is guided to produce only clean images as long as p remains below the practical safety limit.

훈련 중에 사전 정의 된 변환 세트를 사용하여 판별 자에게 표시된 각 이미지를 고정 된 순서로 처리합니다. 증가 강도는 스칼라 p ∈ [0, 1]에 의해 제어되므로 각 변환은 확률 p로 적용되거나 확률 1-p로 건너 뜁니다. 모든 변환에 대해 항상 동일한 p 값을 사용합니다. 무작위 화는 각 확대 및 미니 배치의 각 이미지에 대해 개별적으로 수행됩니다. 파이프 라인에 많은 증가가 있다는 점을 감안할 때 p 값이 매우 작더라도 판별자가 깨끗한 이미지를 볼 가능성이 거의 없습니다 (그림 2c). 그럼에도 불구하고 발생기는 p가 실제 안전 한계 미만으로 유지되는 한 깨끗한 이미지 만 생성하도록 안내됩니다.

In Figure 4 we study the effectiveness of stochastic discriminator augmentation by performing exhaustive sweeps over p for different augmentation categories and dataset sizes.

We observe that it can improve the results significantly in many cases.

However, the optimal augmentation strength depends heavily on the amount of training data, and not all augmentation categories are equally useful in practice.

With a 2k training set, the vast majority of the benefit came from pixel blitting and geometric transforms.

Color transforms were modestly beneficial, while image-space filtering, noise, and cutout were not particularly useful.

In this case, the best results were obtained using strong augmentations.

The curves also indicate some of the augmentations becoming leaky when p → 1.

With a 10k training set, the higher values of p were less helpful, and with 140k the situation was markedly different:

all augmentations were harmful. Based on these results, we choose to use only pixel blitting, geometric, and color transforms for the rest of our tests.

Figure 4d shows that while stronger augmentations reduce overfitting, they also slow down the convergence.

그림 4에서는 다양한 증가 범주 및 데이터 세트 크기에 대해 p에 대한 철저한 스윕을 수행하여 확률 적 판별 자 증가의 효과를 연구합니다. 많은 경우 결과를 크게 향상시킬 수 있습니다. 그러나 최적의 증가 강도는 훈련 데이터의 양에 크게 좌우되며 모든 증가 범주가 실제로 똑같이 유용한 것은 아닙니다. 2k 훈련 세트를 사용하면 대부분의 이점은 픽셀 블리 팅 및 기하학적 변환에서 비롯되었습니다. 색상 변환은 적당히 유익한 반면 이미지 공간 필터링, 노이즈 및 컷 아웃은 특별히 유용하지 않았습니다. 이 경우 강력한 증강을 사용하여 최상의 결과를 얻었습니다. 곡선은 또한 p → 1 일 때 일부 증가가 누출됨을 나타냅니다. 10k 훈련 세트에서는 더 높은 p 값이 덜 도움이되었고 140k에서는 상황이 현저하게 달랐습니다. 모든 증강은 해로 웠습니다. 이러한 결과를 기반으로 나머지 테스트에는 픽셀 블리 팅, 기하학적 및 색상 변환 만 사용하도록 선택합니다. 그림 4d는 강력한 증강이 과적 합을 줄이면서도 수렴 속도를 늦추는 것을 보여줍니다.

In practice, the sensitivity to dataset size mandates a costly grid search, and even so, relying on any fixed p may not be the best choice.

Next, we address these concerns by making the process adaptive.

실제로 데이터 세트 크기에 대한 민감도는 값 비싼 그리드 검색을 요구하며, 그렇더라도 고정 된 p에 의존하는 것은 최선의 선택이 아닐 수 있습니다. 다음으로 프로세스를 적응력있게 만들어 이러한 문제를 해결합니다.

3 Adaptive discriminator augmentation 적응형 판별기 증강

Ideally, we would like to avoid manual tuning of the augmentation strength and instead control it dynamically based on the degree of overfitting.

Figure 1 suggests a few possible approaches for this.

The standard way of quantifying overfitting is to use a separate validation set and observe its behavior relative to the training set.

From the figure we see that when overfitting kicks in, the validation set starts behaving increasingly like the generated images.

This is a quantifiable effect, albeit with the drawback of requiring a separate validation set when training data may already be in short supply.

We can also see that with the non-saturating loss [14] used by StyleGAN2, the discriminator outputs for real and generated images diverge symmetrically around zero as the situation gets worse.

This divergence can be quantified without a separate validation set.

이상적으로는 증가 강도의 수동 조정을 피하고 대신 과적 합 정도에 따라 동적으로 제어하는 것이 좋습니다. 그림 1은 이에 대한 몇 가지 가능한 접근 방식을 제안합니다. 과적 합을 정량화하는 표준 방법은 별도의 검증 세트를 사용하고 훈련 세트와 관련된 동작을 관찰하는 것입니다. 그림에서 과적 합이 시작되면 유효성 검사 세트가 생성 된 이미지처럼 점점 더 작동하기 시작합니다. 훈련 데이터가 이미 부족한 경우 별도의 검증 세트가 필요하다는 단점이 있지만 이는 정량화 가능한 효과입니다. 또한 StyleGAN2에서 사용하는 비 포화 손실 [14]을 사용하면 상황이 악화됨에 따라 실제 및 생성 된 이미지에 대한 판별 기 출력이 0을 중심으로 대칭 적으로 발산하는 것을 볼 수 있습니다. 이 차이는 별도의 검증 세트없이 정량화 할 수 있습니다.

Let us denote the discriminator outputs by Dtrain, Dvalidation, and Dgenerated for the training set, validation set, and generated images, respectively, and their mean over N consecutive minibatches by E[·].

In practice we use N = 4, which corresponds to 4 × 64 = 256 images.

We can now turn our observations about Figure 1 into two plausible overfitting heuristics:

훈련 세트, 검증 세트 및 생성 된 이미지에 대해 각각 Dtrain, Dvalidation 및 Dgenerated로 판별 기 출력을 표시하고 E [·]로 N 연속 미니 배치에 대한 평균을 나타냅니다. 실제로 우리는 4 × 64 = 256 이미지에 해당하는 N = 4를 사용합니다. 이제 그림 1에 대한 관찰을 두 가지 그럴듯한 과적 합 휴리스틱으로 바꿀 수 있습니다.

(1)

For both heuristics, r = 0 means no overfitting and r = 1 indicates complete overfitting, and our goal is to adjust the augmentation probability p so that the chosen heuristic matches a suitable target value.

The first heuristic, rv, expresses the output for a validation set relative to the training set and generated images.

Since it assumes the existence of a separate validation set, we include it mainly as a comparison method.

The second heuristic, rt, estimates the portion of the training set that gets positive discriminator outputs.

We have found this to be far less sensitive to the chosen target value and other hyperparameters than the obvious alternative of looking at E[Dtrain] directly.

두 가지 휴리스틱 모두에 대해 r = 0은 과적 합이 없음을 의미하고 r = 1은 완전한 과적 합을 나타냅니다. 우리의 목표는 선택한 휴리스틱이 적절한 목표 값과 일치하도록 증가 확률 p를 조정하는 것입니다.

첫 번째 휴리스틱 rv는 학습 세트 및 생성 된 이미지와 관련된 검증 세트의 출력을 표현합니다.

별도의 검증 세트가 있다고 가정하므로 주로 비교 방법으로 포함합니다. 두 번째 휴리스틱 rt는 양성 판별 자 출력을 얻는 훈련 세트의 부분을 추정합니다. 우리는 이것이 E [Dtrain]을 직접 보는 명백한 대안보다 선택된 목표 값과 다른 하이퍼 파라미터에 훨씬 덜 민감하다는 것을 발견했습니다.

We control the augmentation strength p as follows.

We initialize p to zero and adjust its value once every four minibatches2 based on the chosen overfitting heuristic.

If the heuristic indicates too much/little overfitting, we counter by incrementing/decrementing p by a fixed amount.

We set the adjustment size so that p can rise from 0 to 1 sufficiently quickly, e.g., in 500k images.

After every step we clamp p from below to 0. We call this variant adaptive discriminator augmentation (ADA).

다음과 같이 증가 강도 p를 제어합니다. 우리는 p를 0으로 초기화하고 선택한 과적 합 휴리스틱을 기반으로 4 개의 미니 배치 2마다 값을 조정합니다. 휴리스틱이 너무 많이 / 약간 과적 합을 나타내면 p를 고정 된 양만큼 증가 / 감소시켜 대응합니다. 조정 크기를 설정하여 p가 0에서 1로 충분히 빠르게 상승 할 수 있습니다 (예 : 500k 이미지). 모든 단계가 끝나면 p를 아래에서 0으로 고정합니다.이 변형을 ADA (Adaptive Discrimental Identifier)라고 부릅니다.

In Figure 5a,b we measure how the target value affects the quality obtainable using these heuristics.

We observe that rv and rt are both effective in preventing overfitting, and that they both improve the results over the best fixed p found using grid search.

We choose to use the more realistic rt heuristic in all subsequent tests, with 0.6 as the target value. Figure 5c shows the resulting p over time.

With a 2k training set, augmentations were applied almost always towards the end.

This exceeds the practical safety limit after which some augmentations become leaky, indicating that the augmentations were not powerful enough.

Indeed, FID started deteriorating after p ≈ 0.5 in this extreme case.

Figure 5d shows the evolution of rt with adaptive vs fixed p, showing that a fixed p tends to be too strong in the beginning and too weak towards the end.

그림 5a, b에서는 이러한 휴리스틱을 사용하여 목표 값이 얻을 수있는 품질에 미치는 영향을 측정합니다. rv와 rt는 모두 과적 합을 방지하는 데 효과적이며 둘 다 그리드 검색을 사용하여 찾은 최상의 고정 p보다 결과를 개선합니다. 모든 후속 테스트에서보다 현실적인 RT 휴리스틱을 사용하기로 선택했습니다. 대상 값은 0.6입니다. 그림 5c는 시간 경과에 따른 결과 p를 보여줍니다. 2k 훈련 세트를 사용하면 거의 항상 마지막에 증강이 적용되었습니다. 이는 실제 안전 한계를 초과 한 후 일부 보강이 누출되어 보강이 충분히 강력하지 않음을 나타냅니다. 실제로이 극단적 인 경우에 FID는 p ≈ 0.5 이후 악화되기 시작했습니다. 그림 5d는 고정 p가 처음에는 너무 강하고 끝으로 갈수록 너무 약한 경향이 있음을 보여주는 적응 형 대 고정 p를 사용한 rt의 진화를 보여줍니다.

Figure 6 repeats the setup from Figure 1 using ADA.

Convergence is now achieved regardless of the training set size and overfitting no longer occurs.

Without augmentations, the gradients the generator receives from the discriminator become very simplistic over time— the discriminator starts to pay attention to only a handful of features, and the generator is free to create otherwise non-sensical images.

With ADA, the gradient field stays much more detailed which prevents such deterioration.

In an interesting parallel, it has been shown that loss functions can be made significantly more robust in regression settings by using similar image augmentation ensembles [23].

그림 6은 ADA를 사용하여 그림 1의 설정을 반복합니다. 이제 훈련 세트 크기에 관계없이 수렴이 이루어지며 더 이상 과적 합이 발생하지 않습니다. 증강이 없으면 생성기가 판별 기로부터받는 기울기는 시간이 지남에 따라 매우 단순 해집니다. 판별 기는 소수의 기능에만주의를 기울이기 시작하고 생성기는 의미없는 이미지를 자유롭게 생성 할 수 있습니다. ADA를 사용하면 그래디언트 필드가 훨씬 더 자세하게 유지되어 이러한 저하를 방지합니다. 흥미롭게도 유사한 이미지 확대 앙상블을 사용하여 회귀 설정에서 손실 함수를 훨씬 더 강력하게 만들 수 있음이 입증되었습니다 [23].

4 Evaluation

We start by testing our method against a number of alternatives in FFHQ and LSUN CAT, first in a setting where a GAN is trained from scratch, then by applying transfer learning on a pre-trained GAN. We conclude with results for several smaller datasets.

먼저 GAN이 처음부터 훈련되는 설정에서 FFHQ 및 LSUN CAT의 여러 대안에 대해 방법을 테스트 한 다음 사전 훈련 된 GAN에 전이 학습을 적용합니다. 여러 개의 작은 데이터 세트에 대한 결과로 결론을 내립니다.

4.1 Training from scratch

Figure 7 shows our results in FFHQ and LSUN CAT across training set sizes, demonstrating that our

adaptive discriminator augmentation (ADA) improves FIDs substantially in limited data scenarios.

We also show results for balanced consistency regularization (bCR) [53], which has not been studied

in the context of limited data before. We find that bCR can be highly effective when the lack of data

is not too severe, but also that its set of augmentations leaks to the generated images. In this example,

we used only xy-translations by integer offsets for bCR, and Figure 7d shows that the generated

images get jittered as a result. This means that bCR is essentially a dataset augmentation and needs

to be limited to symmetries that actually benefit the training data, e.g., x-flip is often acceptable but y-flip only rarely. Meanwhile, with ADA the augmentations do not leak, and thus the same diverse set

of augmentations can be safely used in all datasets. We also find that the benefits for ADA and bCR

are largely additive. We combine ADA and bCR so that ADA is first applied to the input image (real

or generated), and bCR then creates another version of this image using its own set of augmentations.

Qualitative results are shown in Appendix A.

그림 7은 훈련 세트 크기에 따른 FFHQ 및 LSUN CAT의 결과를 보여줍니다. 적응 형 판별 자 증강 (ADA)은 제한된 데이터 시나리오에서 FID를 크게 향상시킵니다. 우리는 또한 연구되지 않은 균형 잡힌 일관성 정규화 (bCR) [53]에 대한 결과를 보여줍니다. 이전에 제한된 데이터의 맥락에서. bCR은 데이터가 부족할 때 매우 효과적 일 수 있습니다. 그다지 심각하지는 않지만 일련의 증강 세트가 생성 된 이미지로 누출됩니다. 이 예에서 우리는 bCR에 대해 정수 오프셋에 의한 xy- 변환 만 사용했으며 그림 7d는 생성 된 그 결과 이미지가 흔들립니다. 이것은 bCR이 본질적으로 데이터 세트 확대이며 실제로 학습 데이터에 도움이되는 대칭으로 제한됩니다. 예를 들어 x-flip은 종종 허용되지만 y-flip은 드물게 만 허용됩니다. 한편, ADA를 사용하면 증강이 누출되지 않으므로 동일한 다양한 세트가 모든 데이터 세트에서 안전하게 사용할 수 있습니다. 또한 ADA 및 bCR의 이점은 크게 추가됩니다. ADA와 bCR을 결합하여 ADA가 입력 이미지 (실제 또는 생성됨), bCR은 자체 증강 세트를 사용하여이 이미지의 다른 버전을 만듭니다. 정 성적 결과는 부록 A에 나와 있습니다.

In Figure 8a we further compare our adaptive augmentation against a wider set of alternatives:

PA-GAN [48], WGAN-GP [15], zCR [53], auxiliary rotations [6], and spectral normalization [31].

We also try modifying our baseline to use a shallower mapping network, which can be trained with less data, borrowing intuition from DeLiGAN [16]. Finally, we try replacing our augmentations with multiplicative dropout [42], whose per-layer strength is driven by our adaptation algorithm.

We spent considerable effort tuning the parameters of all these methods, see Appendix D.

We can see that ADA gave significantly better results than the alternatives.

While PA-GAN is somewhat similar to our method, its checksum task was not strong enough to prevent overfitting in our tests.

Figure 8b shows that reducing the discriminator capacity is generally harmful and does not prevent overfitting.

그림 8a에서 우리는 적응 형 증강을 더 광범위한 대안 세트와 추가로 비교합니다. PA-GAN [48], WGAN-GP [15], zCR [53], 보조 회전 [6] 및 스펙트럼 정규화 [31]. 우리는 또한 더 적은 데이터로 훈련 될 수있는 더 얕은 매핑 네트워크를 사용하도록 기준을 수정하여 DeLiGAN [16]에서 직관을 차용합니다. 마지막으로, 우리는 우리의 적응 알고리즘에 의해 레이어 당 강도가 구동되는 곱셈 드롭 아웃 [42]으로 증강을 대체하려고합니다. 우리는 이러한 모든 방법의 매개 변수를 조정하는 데 상당한 노력을 기울였습니다 (부록 D 참조). ADA가 대안보다 훨씬 더 나은 결과를 제공했음을 알 수 있습니다. PA-GAN은 우리의 방법과 다소 유사하지만 체크섬 작업은 테스트에서 과적 합을 방지 할만큼 강력하지 않았습니다. 그림 8b는 판별 기 용량을 줄이는 것이 일반적으로 해롭고 과적 합을 방지하지 않음을 보여줍니다.

4.2 Transfer learning

Transfer learning reduces the training data requirements by starting from a model trained using some other dataset, instead of a random initialization.

Several authors have explored this in the context of GANs [44, 45, 34], and Mo et al. [33] recently showed strong results by freezing the highest-resolution layers of the discriminator during transfer (Freeze-D).

전이 학습은 임의 초기화 대신 다른 데이터 세트를 사용하여 훈련 된 모델에서 시작하여 훈련 데이터 요구 사항을 줄입니다.

몇몇 저자는 GAN [44, 45, 34]과 Mo et al. [33] 최근에는 전송 중 판별 기 (Freeze-D)의 최고 해상도 레이어를 동결하여 강력한 결과를 보여주었습니다.

We explore several transfer learning setups in Figure 9, using the best Freeze-D configuration found for each case with grid search.

Transfer learning gives significantly better results than from-scratch training, and its success seems to depend primarily on the diversity of the source dataset, instead of the similarity between subjects.

For example, FFHQ (human faces) can be trained equally well from CELEBA-HQ (human faces, low diversity) or LSUN DOG (more diverse). LSUN CAT, however, can only be trained from LSUN DOG, which has comparable diversity, but not from the less diverse datasets.

With small target dataset sizes, our baseline achieves reasonable FID quickly, but the progress soon reverts as training continues.

ADA is again able to prevent the divergence almost completely.

Freeze-D provides a small but reliable improvement when used together with ADA but is not able to prevent the divergence on its own.

그리드 검색과 함께 각 사례에 대해 찾은 최상의 Freeze-D 구성을 사용하여 그림 9에서 여러 전이 학습 설정을 탐색합니다. 전이 학습은 처음부터 학습하는 것보다 훨씬 더 나은 결과를 제공하며, 그 성공은 주로 주제 간의 유사성 대신 소스 데이터 세트의 다양성에 달려있는 것 같습니다. 예를 들어 FFHQ (인간 얼굴)는 CELEBA-HQ (인간 얼굴, 낮은 다양성) 또는 LSUN DOG (더 다양 함)에서 동등하게 잘 훈련 될 수 있습니다. 그러나 LSUN CAT는 비슷한 다양성을 가진 LSUN DOG에서만 훈련 할 수 있지만 덜 다양한 데이터 세트에서는 훈련 할 수 없습니다. 대상 데이터 세트 크기가 작 으면 기준선이 합리적인 FID를 빠르게 달성하지만 교육이 계속되면 진행 상황이 곧 되돌아갑니다. ADA는 다시 분기를 거의 완전히 방지 할 수 있습니다. Freeze-D는 ADA와 함께 사용할 때 작지만 안정적인 개선을 제공하지만 자체적으로 분산을 방지 할 수는 없습니다.

4.3 Small datasets

We tried our method with several datasets that consist of a limited number of training images (Figure 10).

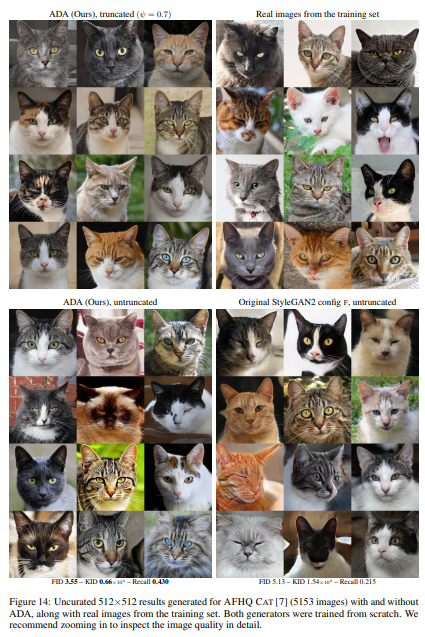

METFACES is our new dataset of 1336 high-quality faces extracted from the collection of Metropolitan Museum of Art (https://metmuseum.github.io/). BRECAHAD [1] consists of only 162 breast cancer histopathology images (1360 × 1024);

we reorganized these into 1944 partially overlapping crops of 5122.

Animal faces (AFHQ) [7] includes ∼5k closeups per category for dogs, cats, and wild life;

we treated these as three separate datasets and trained a separate network for each of them.

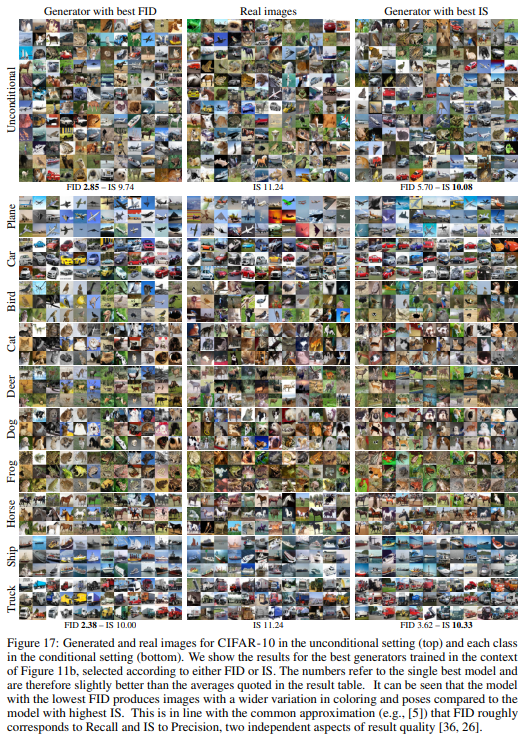

CIFAR-10 includes 50k tiny images in 10 categories [25].

제한된 수의 훈련 이미지로 구성된 여러 데이터 세트로 방법을 시도했습니다 (그림 10). METFACES는 메트로폴리탄 미술관 (https://metmuseum.github.io/) 컬렉션에서 추출한 고품질 얼굴 1336 개의 새로운 데이터 세트입니다. BRECAHAD [1]는 162 개의 유방암 조직 병리학 이미지 (1360 × 1024)로만 구성됩니다. 우리는 이것을 1944 년 5122의 부분적으로 겹치는 작물로 재구성했습니다. 동물 얼굴 (AFHQ) [7]은 개, 고양이, 야생 생물에 대한 카테고리 당 ~ 5k 클로즈업을 포함합니다. 이를 세 개의 개별 데이터 세트로 취급하고 각각에 대해 별도의 네트워크를 훈련 시켰습니다. CIFAR-10은 10 개 카테고리에 5 만 개의 작은 이미지를 포함합니다 [25].

Figure 11 reveals that FID is not an ideal metric for small datasets, because it becomes dominated by the inherent bias when the number of real images is insufficient.

We find that kernel inception distance (KID) [3]— that is unbiased by design — is more descriptive in practice and see that ADA provides a dramatic improvement over baseline StyleGAN2.

This is especially true when training from scratch, but transfer learning also benefits from ADA.

In the widely used CIFAR-10 benchmark, we improve the SOTA FID from 5.59 to 2.42 and inception score (IS) [37] from 9.58 to 10.24 in the class-conditional setting (Figure 11b). This large improvement portrays CIFAR-10 as a limited data benchmark.

We also note that CIFAR-specific architecture tuning had a significant effect.

그림 11은 FID가 실제 이미지 수가 충분하지 않을 때 고유 한 편향에 의해 지배되기 때문에 소규모 데이터 세트에 이상적인 메트릭이 아님을 보여줍니다. 우리는 커널 시작 거리 (KID) [3] (설계에 의해 편파적이지 않음)가 실제로 더 설명 적이며 ADA가 기준 StyleGAN2에 비해 극적인 개선을 제공함을 확인합니다. 이것은 처음부터 훈련 할 때 특히 그러하지 만 전이 학습도 ADA의 혜택을받습니다. 널리 사용되는 CIFAR-10 벤치 마크에서는 클래스 조건 설정에서 SOTA FID를 5.59에서 2.42로, 개시 점수 (IS) [37]를 9.58에서 10.24로 개선했습니다 (그림 11b). 이 큰 개선은 CIFAR-10을 제한된 데이터 벤치 마크로 묘사합니다. 또한 CIFAR 특정 아키텍처 조정이 상당한 영향을 미쳤다는 점에 주목합니다.

5 Conclusions

We have shown that our adaptive discriminator augmentation reliably stabilizes training and vastly improves the result quality when training data is in short supply.

f course, augmentation is not a substitute for real data— one should always try to collect a large, high-quality set of training data first, and only then fill the gaps using augmentation.

As future work, it would be worthwhile to search for the most effective set of augmentations, and to see if recently published techniques, such as the U-net discriminator [38] or multi-modal generator [39], could also help with limited data.

우리는 적응 형 판별 자 증강이 훈련을 안정적으로 안정화하고 훈련 데이터가 부족할 때 결과 품질을 크게 향상 시킨다는 것을 보여주었습니다. f 물론, 증강은 실제 데이터를 대체하는 것이 아닙니다. 항상 대용량의 고품질 훈련 데이터 세트를 먼저 수집 한 다음 증강을 사용하여 차이를 채워야합니다. 향후 작업으로 가장 효과적인 증강 세트를 검색하고 U-net 판별 기 [38] 또는 다중 모달 생성기 [39]와 같은 최근에 발표 된 기술이 제한적인 데이터 문제에 도움이 될 수 있는지 확인하는 것이 좋습니다. .

Enabling ADA has a negligible effect on the energy consumption of training a single model.

As such, using it does not increase the cost of training models for practical use or developing methods that require large-scale exploration.

For reference, Appendix E provides a breakdown of all computation that we performed related to this paper;

the project consumed a total of 325 MWh of electricity, or 135 single-GPU years, the majority of which can be attributed to extensive comparisons and sweeps.

ADA를 활성화하면 단일 모델 학습의 에너지 소비에 거의 영향을 미치지 않습니다. 따라서이를 사용한다고해서 실제 사용을위한 모델 학습이나 대규모 탐색이 필요한 방법 개발 비용이 증가하지 않습니다. 참고로 부록 E는이 백서와 관련하여 수행 한 모든 계산의 분석을 제공합니다. 이 프로젝트는 총 325 MWh의 전기, 즉 135 개의 단일 GPU를 소비했으며, 그 대부분은 광범위한 비교와 스위프에 기인 할 수 있습니다.

Interestingly, the core idea of discriminator augmentations was independently discovered by three other research groups in parallel work: Z. Zhao et al. [54], Tran et al. [43], and S. Zhao et al. [51].

We recommend these papers as they all offer a different set of intuition, experiments, and theoretical justifications.

While two of these papers [54, 51] propose essentially the same augmentation mechanism as we do, they study the absence of leak artifacts only empirically.

The third paper [43] presents a theoretical justification based on invertibility, but arrives at a different argument that leads to a more complex network architecture, along with significant restrictions on the set of possible augmentations.

None of these works consider the possibility of tuning augmentation strength adaptively.

Our experiments in Section 3 show that the optimal augmentation strength not only varies between datasets of different content and size, but also over the course of training — even an optimal set of fixed augmentation parameters is likely to leave performance on the table.

흥미롭게도 판별 자 증가의 핵심 아이디어는 병렬 작업에서 다른 세 개의 연구 그룹에 의해 독립적으로 발견되었습니다. Z. Zhao et al. [54], Tran et al. 및 S. Zhao et al. [51]. 이 논문은 모두 다른 직관, 실험 및 이론적 정당성을 제공하므로 권장합니다. 이 논문들 중 두 개 [54, 51]는 본질적으로 우리가하는 것과 동일한 증강 메커니즘을 제안하지만, 그들은 단지 경험적으로 만 누출 아티팩트의 부재를 연구합니다. 세 번째 논문 [43]은 가역성에 기반한 이론적 정당성을 제시하지만 가능한 증강 세트에 대한 상당한 제한과 함께 더 복잡한 네트워크 아키텍처로 이어지는 다른 주장에 도달합니다. 이 작품들 중 어느 것도 적응 적으로 증가 강도를 조정할 가능성을 고려하지 않습니다. 섹션 3의 실험은 최적의 증강 강도가 다양한 콘텐츠 및 크기의 데이터 세트간에 다를뿐만 아니라 훈련 과정에서도 다양 함을 보여줍니다. 고정 된 증강 매개 변수의 최적 세트조차도 성능을 테이블에 남길 가능성이 높습니다.

A direct comparison of results between the parallel works is difficult because the only dataset used in all papers is CIFAR-10.

Regrettably, the other three papers compute FID using 10k generated images and 10k validation images (FID-10k), while we use follow the original recommendation of Heusel et al. [18] and use 50k generated images and all training images.

Their FID-10k numbers are thus not comparable to the FIDs in Figure 11b.

For this reason we also computed FID-10k for our method, obtaining 7.01 ± 0.06 for unconditional and 6.54 ± 0.06 for conditional.

These compare favorably to parallel work’s unconditional 9.89 [51] or 10.89 [43], and conditional 8.30 [54] or 8.49[51].

It seems likely that some combination of the ideas from all four papers could further improve our results.

For example, more diverse set of augmentations or contrastive regularization [54] might be worth testing.

모든 논문에서 사용되는 유일한 데이터 세트가 CIFAR-10이기 때문에 병렬 작업 간의 결과를 직접 비교하는 것은 어렵습니다. 유감스럽게도 다른 세 논문은 생성 된 10k 이미지와 10k 유효성 검사 이미지 (FID-10k)를 사용하여 FID를 계산하지만 Heusel et al.의 원래 권장 사항을 따릅니다. [18] 50k 생성 이미지와 모든 훈련 이미지를 사용합니다. 따라서 FID-10k 번호는 그림 11b의 FID와 비교할 수 없습니다. 이러한 이유로 우리는 또한 우리의 방법에 대해 FID-10k를 계산하여 무조건의 경우 7.01 ± 0.06, 조건의 경우 6.54 ± 0.06을 얻었습니다. 이것은 병렬 작업의 무조건 9.89 [51] 또는 10.89 [43] 및 조건부 8.30 [54] 또는 8.49 [51]에 비해 유리합니다. 네 가지 논문의 아이디어를 조합하면 결과를 더욱 향상시킬 수있을 것 같습니다. 예를 들어,보다 다양한 증강 세트 또는 대조적 정규화 [54]는 테스트 할 가치가 있습니다.

Broader impact

Data-driven generative modeling means learning a computational recipe for generating complicated data based purely on examples.

This is a foundational problem in machine learning.

In addition to their fundamental nature, generative models have several uses within applied machine learning research as priors, regularizers, and so on. In those roles, they advance the capabilities of computer vision and graphics algorithms for analyzing and synthesizing realistic imagery.

데이터 기반 생성 모델링은 순전히 예제를 기반으로 복잡한 데이터를 생성하기위한 계산 방법을 학습하는 것을 의미합니다. 이것은 기계 학습의 근본적인 문제입니다. 기본 특성 외에도 생성 모델은 적용된 기계 학습 연구 내에서 사전, 정규화 등 여러 용도로 사용됩니다. 이러한 역할에서 그들은 사실적인 이미지를 분석하고 합성하기위한 컴퓨터 비전 및 그래픽 알고리즘의 기능을 발전시킵니다.

The methods presented in this work enable high-quality generative image models to be trained using significantly less data than required by existing approaches.

It thereby primarily contributes to the deep technical question of how much data is enough for generative models to succeed in picking up the necessary commonalities and relationships in the data.

이 작업에 제시된 방법을 사용하면 기존 접근 방식에서 요구하는 것보다 훨씬 적은 데이터를 사용하여 고품질 생성 이미지 모델을 훈련 할 수 있습니다. 따라서 생성 모델이 데이터에서 필요한 공통성과 관계를 성공적으로 선택하는 데 얼마나 많은 데이터가 충분한 지에 대한 깊은 기술적 질문에 주로 기여합니다.

From an applied point of view, this work contributes to efficiency; it does not introduce fundamental new capabilities.

Therefore, it seems likely that the advances here will not substantially affect the overall themes— surveillance, authenticity, privacy, etc.— in the active discussion on the broader impacts of computer vision and graphics.

적용 관점에서이 작업은 효율성에 기여합니다. 근본적인 새로운 기능을 소개하지는 않습니다. 따라서 여기에서의 발전은 컴퓨터 비전 및 그래픽의 광범위한 영향에 대한 적극적인 논의에서 감시, 진정성, 개인 정보 보호 등 전반적인 주제에 실질적으로 영향을 미치지 않을 것으로 보입니다.

Specifically, generative models’ implications on image and video authenticity is a topic of active discussion.

Most attention revolves around conditional models that allow semantic control and sometimes manipulation of existing images. Our algorithm does not offer direct controls for highlevel attributes (e.g., identity, pose, expression of people) in the generated images, nor does it enable direct modification of existing images.

However, over time and through the work of other researchers, our advances will likely lead to improvements in these types of models as well.

특히, 이미지 및 비디오 진정성에 대한 생성 모델의 의미는 활발한 논의 주제입니다. 대부분의 관심은 의미 론적 제어를 허용하고 때로는 기존 이미지를 조작 할 수있는 조건부 모델을 중심으로합니다. 당사의 알고리즘은 생성 된 이미지에서 높은 수준의 속성 (예 : 신원, 포즈, 사람 표현)에 대한 직접적인 제어를 제공하지 않으며 기존 이미지를 직접 수정할 수 없습니다. 그러나 시간이 지남에 따라 다른 연구자들의 작업을 통해 우리의 발전은 이러한 유형의 모델에서도 개선 될 것입니다.

The contributions in this work make it easier to train high-quality generative models with custom sets of images.

By this, we eliminate, or at least significantly lower, the barrier for applying GAN-type models in many applied fields of research.

We hope and believe that this will accelerate progress in several such fields.

For instance, modeling the space of possible appearance of biological specimens (tissues, tumors, etc.) is a growing field of research that appears to chronically suffer from limited high-quality data.

Overall, generative models hold promise for increased understanding of the complex and hard-to-pinpoint relationships in many real-world phenomena; our work hopefully increases the breadth of phenomena that can be studied.

이 작업의 기여로 사용자 지정 이미지 세트로 고품질 생성 모델을보다 쉽게 학습시킬 수 있습니다. 이를 통해 우리는 많은 응용 연구 분야에서 GAN 유형 모델을 적용하는 장벽을 제거하거나 최소한 크게 낮 춥니 다. 우리는 이것이 그러한 여러 분야에서 진전을 가속화하기를 희망하고 믿습니다. 예를 들어 생물학적 표본 (조직, 종양 등)이 나타날 수있는 공간을 모델링하는 것은 제한된 고품질 데이터로 인해 만성적으로 고통받는 것으로 보이는 연구 분야입니다. 전반적으로, 생성 모델은 많은 실제 현상에서 복잡하고 정확한 관계에 대한 이해를 높일 수있는 가능성이 있습니다. 우리의 작업은 연구 할 수있는 현상의 폭을 넓 히길 바랍니다.

A Additional results

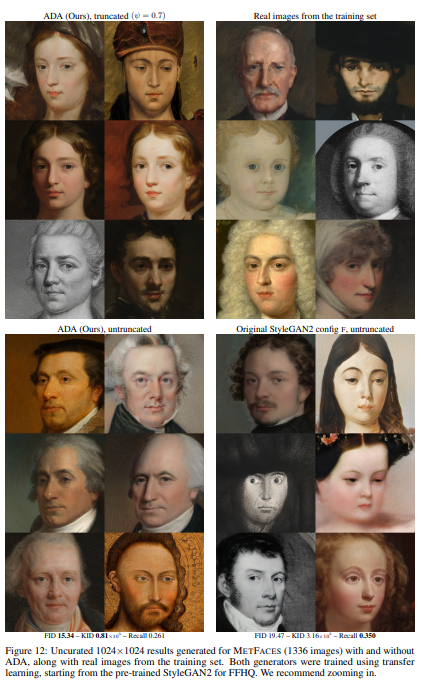

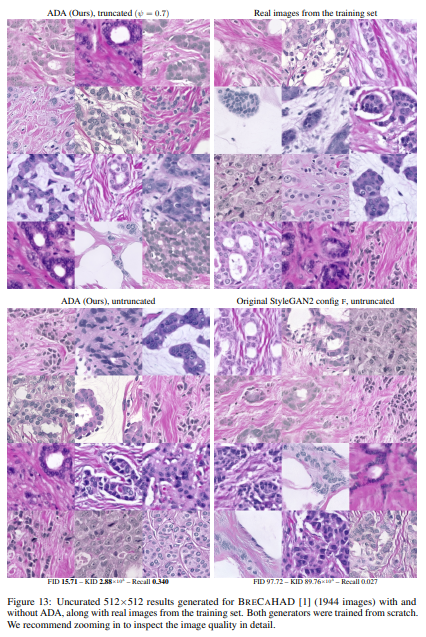

In Figures 12, 13, 14, 15, and 16, we show generated images for METFACES, BRECAHAD, and AFHQ CAT, DOG, WILD, respectively, along

with real images from the respective training sets (Section 4.3 and Figure 11a). The images were selected at random; we did not perform any cherrypicking besides choosing one global random seed. We can see that ADA yields excellent results in all cases, and with slight truncation [29, 20], virtually all of the images look convincing. Without ADA, the convergence is hampered by discriminator overfitting, leading to inferior image quality for the original StyleGAN2, especially in METFACES, AFHQ DOG, and BRECAHAD.

그림 12, 13, 14, 15 및 16에서는 METFACES, BRECAHAD 및 AFHQ CAT, DOG, WILD에 대해 각각 생성 된 이미지와 각 훈련 세트의 실제 이미지를 보여줍니다 (섹션 4.3 및 그림 11a). 이미지는 무작위로 선택되었습니다. 우리는 하나의 글로벌 랜덤 시드를 선택하는 것 외에 어떤 체리 피킹도 수행하지 않았습니다. 우리는 ADA가 모든 경우에서 우수한 결과를 산출하고 약간의 잘림 [29, 20]을 통해 사실상 모든 이미지가 설득력있게 보입니다. ADA가 없으면 판별 자 과적 합으로 수렴이 방해를 받아 원래 StyleGAN2, 특히 METFACES, AFHQ DOG 및 BRECAHAD에서 이미지 품질이 저하됩니다.

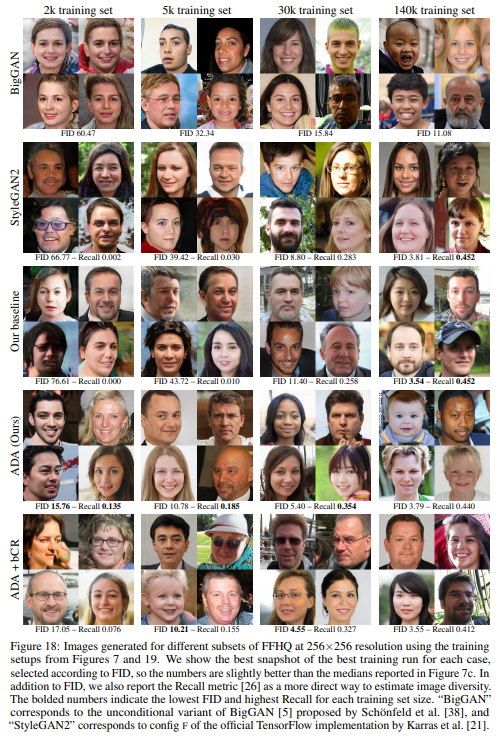

Figure 17 shows examples of the generated CIFAR-10 images in both unconditional and classconditional setting (See Appendix D.1 for details on the conditional setup). Figure 18 shows qualitative results for different methods using subsets of FFHQ at 256×256 resolution. Methods that do not employ augmentation (BigGAN, StyleGAN2, and our baseline) degrade noticeably as the size of the training set decreases, generally yielding poor image quality and diversity with fewer than 30k training images. With ADA, the degradation is much more graceful, and the results remain reasonable even with a 5k training set.

그림 17은 무조건 및 클래스 조건 설정 모두에서 생성 된 CIFAR-10 이미지의 예를 보여줍니다 (조건부 설정에 대한 자세한 내용은 부록 D.1 참조).

그림 18은 256x256 해상도에서 FFHQ의 하위 집합을 사용하는 다양한 방법에 대한 정 성적 결과를 보여줍니다.

증강을 사용하지 않는 방법 (BigGAN, StyleGAN2 및 기준)은 훈련 세트의 크기가 감소함에 따라 눈에 띄게 저하되며 일반적으로 3 만 개 미만의 훈련 이미지로 이미지 품질과 다양성이 저하됩니다. ADA를 사용하면 성능 저하가 훨씬 더 우아하고 결과는 5k 훈련 세트로도 합리적입니다.

Figure 19 compares our results with unconditional BigGAN [5, 38] and StyleGAN2 config F [21].

BigGAN was very unstable in our experiments: while some of the results were quite good, approximately 50% of the training runs failed to converge. StyleGAN2, on the other hand, behaved predictably, with different training runs resulting in nearly identical FID. We note that FID has a general tendency to increase as the training set gets smaller— not only because of the lower image quality, but also due to inherent bias in FID itself [3]. In our experiments, we minimize the impact of this bias by always computing FID between 50k generated images and all available real images, regardless of which subset was used for training. To estimate the magnitude of bias in FID, we simulate a hypothetical generator that replicates the training set as-is, and compute the average FID over 100 random trials with different subsets of training data; the standard deviation was ≤2% in all cases. We can see that the bias remains negligible with ≥20k training images but starts to dominate with ≤2k. Interestingly, ADA reaches the same FID as the best-case generator with FFHQ-1k, indicating that FID is no longer able to differentiate between the two in this case.

그림 19는 무조건 BigGAN [5, 38] 및 StyleGAN2 config F [21]의 결과를 비교합니다. BigGAN은 실험에서 매우 불안정했습니다. 일부 결과는 꽤 좋았지 만 훈련 실행의 약 50 %가 수렴하지 못했습니다. 반면 StyleGAN2는 서로 다른 훈련 실행으로 거의 동일한 FID를 생성하여 예측 가능하게 작동했습니다. FID는 학습 세트가 작아 질수록 증가하는 일반적인 경향이 있습니다. 이미지 품질이 낮을뿐만 아니라 FID 자체의 고유 한 편향 때문이기도합니다 [3]. 실험에서는 훈련에 사용 된 하위 집합에 관계없이 생성 된 50k 이미지와 사용 가능한 모든 실제 이미지 사이의 FID를 항상 계산하여이 편향의 영향을 최소화합니다. FID의 편향의 크기를 추정하기 위해 훈련 세트를있는 그대로 복제하는 가상 생성기를 시뮬레이션하고 훈련 데이터의 다른 하위 집합을 사용하여 100 번의 무작위 시도에 대한 평균 FID를 계산합니다. 표준 편차는 모든 경우에 ≤2 %였습니다. 20,000 개 이상의 트레이닝 이미지에서는 편향이 무시할 수 있지만 ≤2k로 우세하기 시작한다는 것을 알 수 있습니다. 흥미롭게도 ADA는 FFHQ-1k를 사용하는 최상의 경우 생성기와 동일한 FID에 도달하여이 경우 FID가 더 이상 둘을 구분할 수 없음을 나타냅니다.

Figure 20 shows additional examples of bCR leaking to generated images and compares bCR with dataset augmentation. In particular, rotations in range [−45◦ , +45◦ ] (denoted ±45◦ ) serve as a very clear example that attempting to make the discriminator blind to certain transformations opens up the possibility for the generator to produce similarly transformed images with no penalty. In applications where such leaks are acceptable, one can employ either bCR or dataset augmentation — we find that it is difficult to predict which method is better. For example, with translation augmentations bCR was significantly better than dataset augmentation, whereas x-flip was much more effective when implemented as a dataset augmentation.

그림 20은 생성 된 이미지로 유출되는 bCR의 추가 예를 보여주고 bCR을 데이터 세트 증가와 비교합니다. 특히 범위 [−45◦, + 45◦] (± 45◦로 표시)의 회전은 판별기를 특정 변환에 대해 차단하려고 시도하면 생성기가 다음과 같이 유사하게 변환 된 이미지를 생성 할 수있는 가능성을 열어주는 매우 명확한 예입니다. 벌금이 없습니다. 이러한 누출이 허용되는 애플리케이션에서는 bCR 또는 데이터 세트 증가를 사용할 수 있습니다. 어떤 방법이 더 나은지 예측하기가 어렵습니다. 예를 들어, 번역 증강을 사용하면 bCR이 데이터 세트 증강보다 훨씬 더 나은 반면, x-flip은 데이터 세트 증강으로 구현 될 때 훨씬 더 효과적이었습니다.

Finally, Figure 21 shows an extended version of Figure 4, illustrating the effect of different augmentation categories with increasing augmentation probability p. Blit + Geom + Color yielded the best results with a 2k training set and remained competitive with larger training sets as well.

마지막으로, 그림 21은 그림 4의 확장 버전을 보여 주며, 증가 확률 p가 증가함에 따라 다양한 증가 범주의 효과를 보여줍니다. Blit + Geom + Color는 2k 훈련 세트에서 최상의 결과를 얻었으며 더 큰 훈련 세트에서도 경쟁력을 유지했습니다.

B Our augmentation pipeline

We designed our augmentation pipeline based on three goals. First, the entire pipeline must be strictly non-leaking (Appendix C). Second, we aim for a maximally diverse set of augmentations, inspired by the success of RandAugment [9]. Third, we strive for the highest possible image quality to reduce unintended artifacts such as aliasing. In total, our pipeline consists of 18 transformations: geometric (7), color (5), filtering (4), and corruption (2). We implement it entirely on the GPU in a differentiable fashion, with full support for batching. All parameters are sampled independently for each image.

우리는 세 가지 목표를 기반으로 증강 파이프 라인을 설계했습니다. 첫째, 전체 파이프 라인은 엄격하게 누출되지 않아야합니다 (부록 C). 둘째, 우리는 RandAugment [9]의 성공에 영감을 받아 최대한 다양한 증강 세트를 목표로합니다. 셋째, 앨리어싱과 같은 의도하지 않은 아티팩트를 줄이기 위해 가능한 최고의 이미지 품질을 위해 노력합니다. 전체적으로 파이프 라인은 기하학적 (7), 색상 (5), 필터링 (4) 및 손상 (2)의 18 가지 변환으로 구성됩니다. 우리는 일괄 처리를 완벽하게 지원하여 차별화 가능한 방식으로 GPU에서 전적으로 구현합니다. 모든 매개 변수는 각 이미지에 대해 독립적으로 샘플링됩니다.

B.1 Geometric and color transformations 기하학적 및 색상 변환

Figure 22 shows pseudocode for our geometric and color transformations, along with example images. In general, geometric transformations tend to lose high-frequency details of the input image due to uneven resampling, which may reduce the capability of the discriminator to detect pixel-level errors in the generated images. We alleviate this by introducing a dedicated sub-category, pixel blitting, that only copies existing pixels as-is, without blending between neighboring pixels. Furthermore, we avoid gradual image degradation from multiple consecutive transformations by collapsing all geometric transformations into a single combined operation.

그림 22는 예제 이미지와 함께 기하학적 및 색상 변환에 대한 의사 코드를 보여줍니다. 일반적으로 기하학적 변환은 고르지 않은 리샘플링으로 인해 입력 이미지의 고주파 세부 정보를 잃는 경향이 있으며, 이는 생성 된 이미지에서 픽셀 수준 오류를 감지하는 판별 기의 기능을 감소시킬 수 있습니다. 인접한 픽셀을 혼합하지 않고 기존 픽셀 만 그대로 복사하는 전용 하위 범주 인 픽셀 블리 팅을 도입하여이를 완화합니다. 또한 모든 기하학적 변환을 단일 결합 작업으로 축소하여 여러 연속 변환으로 인한 점진적인 이미지 저하를 방지합니다.

The parameters for pixel blitting are selected on lines 5–15, consisting of x-flips (line 7), 90◦ rotations (line 10), and integer translations (line 13). The transformations are accumulated into a homogeneous 3 × 3 matrix G, defined so that input pixel (xi , yi) is placed at [xo, yo, 1]T = G · [xi , yi , 1]T in the output. The origin is located at the center of the image and neighboring pixels are spaced at unit intervals. We apply each transformation with probability p by sampling its parameters from uniform distribution, either discrete U{·} or continuous U(·), and updating G using elementary transforms: (2)

픽셀 블리 팅에 대한 매개 변수는 x-flip (7 행), 90 ° 회전 (10 행) 및 정수 변환 (13 행)으로 구성된 5-15 행에서 선택됩니다. 변환은 균질 한 3 × 3 행렬 G로 누적되며, 입력 픽셀 (xi, yi)이 출력에서 [xo, yo, 1] T = G · [xi, yi, 1] T에 배치되도록 정의됩니다. 원점은 이미지의 중앙에 있으며 인접 픽셀은 단위 간격으로 배치됩니다. 이산 U {·} 또는 연속 U (·)의 균일 분포에서 매개 변수를 샘플링하고 기본 변환을 사용하여 G를 업데이트하여 확률 p로 각 변환을 적용합니다. (2)

SCALE2D(sx, sy) = " sx 0 0 0 sy 0 0 0 1# , ROTATE2D(θ) = " cos θ − sin θ 0 sin θ cos θ 0 0 0 1# , TRANSLATE2D(tx, ty) = " 1 0 tx 0 1 ty 0 0 1 # (2)

General geometric transformations are handled in a similar way on lines 16–32, consisting of isotropic scaling (line 17), arbitrary rotation (lines 21 and 27), anisotropic scaling (line 24), and fractional translation (line 30). Since both of the scaling transformations are multiplicative in nature, we sample their parameter, s, from a log-normal distribution so that ln s ∼ N 0,(0.2 · ln 2)2 . In practice, this can be done by first sampling t ∼ N (0, 1) and then calculating s = exp2 (0.2t). We allow anisotropic scaling to operate in other directions besides the coordinate axes by breaking the rotation into two independent parts, one applied before the scaling (line 21) and one after it (line 27). We apply the rotations slightly less frequently than other transformations, so that the probability of applying at least one rotation is equal to p. Note that we also have two translations in our pipeline (lines 13 and 30), one applied at the beginning and one at the end. To increase the diversity of our augmentations, we use U(·) for the former and N (·) for the latter.

일반적인 기하학적 변환은 등방성 스케일링 (라인 17), 임의 회전 (라인 21 및 27), 비 등방성 스케일링 (라인 24) 및 부분 변환 (라인 30)으로 구성된 라인 16-32에서 유사한 방식으로 처리됩니다. 두 스케일링 변환은 본질적으로 곱하기 때문에 ln s ∼ N 0, (0.2 · ln 2) 2가되도록 로그 정규 분포에서 매개 변수 s를 샘플링합니다. 실제로 이것은 먼저 t ∼ N (0, 1)을 샘플링 한 다음 s = exp2 (0.2t)를 계산하여 수행 할 수 있습니다. 회전을 두 개의 독립적 인 부분으로 분할하여 비 등방성 스케일링이 좌표축 이외의 다른 방향으로 작동 할 수 있도록합니다. 하나는 스케일링 이전에 적용되고 (라인 21) 다른 하나는 이후에 적용됩니다 (라인 27). 회전을 다른 변환보다 약간 덜 자주 적용하므로 적어도 하나의 회전을 적용 할 확률은 p와 같습니다. 또한 파이프 라인에 두 개의 번역 (13 및 30 행)이 있습니다. 하나는 처음에 적용되고 다른 하나는 끝에 적용됩니다. 증강의 다양성을 높이기 위해 전자에 U (·)를 사용하고 후자에 N (·)을 사용합니다.

Once the parameters are settled, the combined geometric transformation is executed on lines 33–47. We avoid undesirable effects at image borders by first padding the image with reflection. The amount of padding is calculated dynamically based on G so that none of the output pixels are affected by regions outside the image (line 35). We then upsample the image to a higher resolution (line 40) and transform it using bilinear interpolation (line 45). Operating at a higher resolution is necessary to reduce aliasing when the image is minified, e.g., as a result of isotropic scaling— interpolating at the original resolution would fail to correctly filter out frequencies above Nyquist in this case, no matter which interpolation filter was used. The choice of the upsampling filter requires some care, however, because we must ensure that an identity transform does not modify the image in any way (e.g., when p = 0). In other words, we need to use a lowpass filter H(z) with cutoff fc = π 2 that satisfies DOWNSAMPLE2D UPSAMPLE2D Y, H(z −1 ) , H(z) = Y . Luckily, existing literature on wavelets [10] offers a wide selection of such filters; we choose 12-tap symlets (SYM6) to strike a balance between resampling quality and computational cost.

매개 변수가 정해지면 결합 된 기하학적 변환이 33-47 행에서 실행됩니다. 먼저 이미지를 반사로 패딩하여 이미지 테두리에서 원하지 않는 효과를 방지합니다. 패딩의 양은 G를 기반으로 동적으로 계산되므로 출력 픽셀은 이미지 외부 영역의 영향을받지 않습니다 (라인 35). 그런 다음 이미지를 더 높은 해상도 (라인 40)로 업 샘플링하고 쌍 선형 보간 (라인 45)을 사용하여 변환합니다. 예를 들어 등방성 스케일링의 결과로 이미지가 축소 될 때 앨리어싱을 줄이려면 더 높은 해상도에서 작동해야합니다.이 경우 원래 해상도로 보간하면 어떤 보간 필터가 사용되었는지에 관계없이 Nyquist 이상의 주파수를 올바르게 필터링하지 못합니다. . 그러나 업 샘플링 필터를 선택할 때는 약간의주의가 필요합니다. 왜냐하면 신원 변환이 어떤 방식으로도 이미지를 수정하지 않도록해야하기 때문입니다 (예 : p = 0 일 때). 즉, DOWNSAMPLE2D UPSAMPLE2D Y, H (z −1), H (z) = Y를 충족하는 컷오프 fc = π 2 인 저역 통과 필터 H (z)를 사용해야합니다. 다행히도 웨이블릿에 대한 기존 문헌 [10]은 이러한 필터의 다양한 선택을 제공합니다. 리샘플링 품질과 계산 비용 간의 균형을 맞추기 위해 12 탭 symlet (SYM6)을 선택합니다.

Finally, color transformations are applied to the resulting image on lines 48–70. The overall operation is similar to geometric transformations: we collect the parameters of each individual transformation into a homogeneous 4 × 4 matrix C that we then apply to each pixel by computing [ro, go, bo, 1]T = C · [ri , gi , bi , 1]T . The transformations include adjusting brightness (line 50), contrast (line 53), and saturation (line 63), as well as flipping the luma axis while keeping the chroma unchanged (line 57) and rotating the hue axis by an arbitrary amount (line 60).

마지막으로 48 ~ 70 행의 결과 이미지에 색상 변환이 적용됩니다. 전체 작업은 기하학적 변환과 유사합니다. 각 개별 변환의 매개 변수를 동종 4 × 4 행렬 C로 수집 한 다음 [ro, go, bo, 1] T = C · [ri, gi, bi, 1] T. 변환에는 밝기 (라인 50), 대비 (라인 53) 및 채도 (라인 63) 조정, 채도를 변경하지 않고 (라인 57) 색조 축을 임의의 양만큼 회전 (라인 60).

B.2 Image-space filtering and corruptions 이미지 공간 필터링 및 손상

Figure 23 shows pseudocode for our image-space filtering and corruptions. The parameters for image space filtering are selected on lines 5–14. The idea is to divide the frequency content of the image into 4 non-overlapping bands and amplify/weaken each band in turn via a sequence of 4 transformations, so that each transformation is applied independently with probability p (lines 9–10). Frequency bands b2, b3, and b4 correspond to the three highest octaves, respectively, while the remaining low frequencies are attributed to b1 (line 6). We track the overall gain of each band using vector g (line 7) that we update after each transformation (line 14). We sample the amplification factor for a given band from log-normal distribution (line 12), similar to geometric scaling, and normalize the overall gain so that the total energy is retained on expectation. For the normalization, we assume that the frequency content obeys 1/f power spectrum typically seen in natural images (line 8). While this assumption is not strictly true in our case, especially when some of the previous frequency bands have already been amplified, it is sufficient to keep the output pixel values within reasonable bounds.

그림 23은 이미지 공간 필터링 및 손상에 대한 의사 코드를 보여줍니다. 이미지 공간 필터링을위한 매개 변수는 라인 5-14에서 선택됩니다. 아이디어는 이미지의 주파수 내용을 4 개의 겹치지 않는 밴드로 나누고 4 개의 변환 시퀀스를 통해 차례로 각 밴드를 증폭 / 약화시켜 각 변환이 확률 p (9-10 행)로 독립적으로 적용되도록하는 것입니다. 주파수 대역 b2, b3 및 b4는 각각 가장 높은 세 옥타브에 해당하고 나머지 저주파는 b1 (6 행)에 해당합니다. 각 변환 (14 행) 후 업데이트하는 벡터 g (7 행)를 사용하여 각 대역의 전체 이득을 추적합니다. 기하학적 스케일링과 유사한 로그 정규 분포 (라인 12)에서 주어진 대역에 대한 증폭 계수를 샘플링하고 총 에너지가 예상대로 유지되도록 전체 이득을 정규화합니다. 정규화를 위해 주파수 성분이 일반적으로 자연 이미지에서 볼 수있는 1 / f 전력 스펙트럼을 따른다고 가정합니다 (8 행). 이 가정은 우리의 경우, 특히 이전 주파수 대역 중 일부가 이미 증폭 된 경우에는 엄격히 사실이 아니지만 출력 픽셀 값을 합리적인 범위 내로 유지하는 것으로 충분합니다.

The filtering is executed on lines 15–23. We first construct a combined amplification filter H0 (z) (lines 17–19) and then perform separable convolution for the image using reflection padding (lines 21– 23). We use a zero-phase filter bank derived from 4-tap symlets (SYM2) [10]. Denoting the wavelet scaling filter by H(z), the corresponding bandpass filters are obtained as follows (line 19):

필터링은 15-23 행에서 실행됩니다. 먼저 결합 된 증폭 필터 H0 (z) (17 ~ 19 행)을 구성한 다음 반사 패딩 (21 ~ 23 행)을 사용하여 이미지에 대해 분리 가능한 회선을 수행합니다. 4 탭 symlet (SYM2)에서 파생 된 영 위상 필터 뱅크를 사용합니다 [10]. 웨이블릿 스케일링 필터를 H (z)로 표시하면 해당 대역 통과 필터가 다음과 같이 얻어집니다 (19 행).

Finally, we apply additive RGB noise on lines 24–29 and cutout on lines 30–35. We vary the strength of the noise by sampling its standard deviation from half-normal distribution, i.e., N (·) restricted to non-negative values (line 26). For cutout, we match the original implementation of DeVries and Taylor [11] by setting pixels to zero within a rectangular area of size w 2 , h 2 , with the center point selected from uniform distribution over the entire image.

마지막으로 24 ~ 29 행에 추가 RGB 노이즈를 적용하고 30 ~ 35 행에 컷 아웃을 적용합니다. 정규 분포의 절반, 즉 음이 아닌 값으로 제한된 N (·) (26 행)에서 표준 편차를 샘플링하여 노이즈의 강도를 변경합니다. 컷 아웃의 경우, 전체 이미지에 대한 균일 한 분포에서 선택된 중심점을 사용하여 크기 w 2, h 2의 직사각형 영역 내에서 픽셀을 0으로 설정하여 DeVries 및 Taylor [11]의 원래 구현과 일치시킵니다.

C Non-leaking augmentations 비누출 증가

The goal of GAN training is to find a generator function G whose output probability distribution x (under suitable stochastic input) matches a given target distribution y.

GAN 훈련의 목표는 출력 확률 분포 x (적절한 확률 적 입력에서)가 주어진 목표 분포 y와 일치하는 생성기 함수 G를 찾는 것입니다

When augmenting both the dataset and the generator output, the key safety principle is that if x and y do not match, then their augmented versions must not match either. If the augmentation pipeline violates this principle, the generator is free to learn some different output distribution than the dataset, as these look identical after the augmentations – we say that the augmentations leak. Conversely, if the principle holds, then the only option for the generator is to learn the correct distribution: no other choice results in a post-augmentation match.

데이터 세트와 생성기 출력을 모두 증가시킬 때 주요 안전 원칙은 x와 y가 일치하지 않으면 해당 증가 버전도 일치하지 않아야한다는 것입니다. 증강 파이프 라인이이 원칙을 위반하는 경우 생성기는 데이터 세트와 다른 출력 분포를 자유롭게 학습 할 수 있습니다. 이는 증강 후 동일 해 보이기 때문입니다. 우리는 증강이 누출된다고 말합니다. 반대로 원칙이 유지되는 경우 생성기의 유일한 옵션은 올바른 분포를 배우는 것입니다. 다른 선택은 증가 후 일치를 초래하지 않습니다.

In this section, we study the conditions on the augmentation pipeline under which this holds and demonstrate the safety and caveats of various common augmentations and their compositions.

이 섹션에서는 다양한 일반적인 증강 및 그 구성의 안전성과주의 사항을 유지하고 입증하는 증강 파이프 라인의 조건을 연구합니다.

표기법이 섹션 전체에서 소문자 굵은 글씨 (예 : x)를 사용하는 확률 분포 (및 일반화), 붓글씨 (T)로 작업하는 연산자, 대문자 (X)로 확률 분포에서 샘플링 된 변수를 표시합니다. ).

Notation Throughout this section, we denote probability distributions (and their generalizations) with lowercase bold-face letters (e.g., x), operators acting on them by calligraphic letters (T ), and variates sampled from probability distributions by upper-case letters (X).

표기법이 섹션에서는 소문자 굵은 글씨체 (예 : x)를 사용하는 확률 분포 (및 일반화), 붓글씨 (T)로 작동하는 연산자, 대문자 (X)로 확률 분포에서 샘플링 한 변수를 표시합니다. ).

C.1 Augmentation operator 증강 연산자

A very general model for augmentations is as follows. Assume a fixed but arbitrarily complicated nonlinear and stochastic augmentation pipeline. To any image X, it assigns a distribution of augmented images, such as demonstrated in Figure 2c. This idea is captured by an augmentation operator T that maps probability distributions to probability distributions (or, informally, datasets to augmented datasets). A distribution with the lone image X is the Dirac point mass δX, which is mapped to some distribution T δX of augmented images.3 In general, applying T to an arbitrary distribution x yields the linear superposition T x of such augmented distributions.

증강에 대한 매우 일반적인 모델은 다음과 같습니다. 고정되었지만 임의적으로 복잡한 비선형 및 확률 적 증대 파이프 라인을 가정합니다. 모든 이미지 X에 그림 2c와 같이 증강 이미지의 분포를 할당합니다. 이 아이디어는 확률 분포를 확률 분포 (또는 비공식적으로 데이터 세트를 증강 데이터 세트로)로 매핑하는 증강 연산자 T에 의해 포착됩니다. 고독한 이미지 X가있는 분포는 Dirac 포인트 질량 δX이며, 이는 증강 이미지의 일부 분포 T δX에 매핑됩니다 .3 일반적으로 임의 분포 x에 T를 적용하면 이러한 증강 분포의 선형 중첩 T x가 생성됩니다.

It is important to understand that T is different from a function f(X; φ) that actually applies the augmentation on any individual image X sampled from x (parametrized by some φ, e.g., angle in case of a rotation augmentation). It captures the aggregate effect of applying this function on all images in the distribution and subsumes the randomization of the function parameters. T is always linear and deterministic, regardless of non-linearity of the function f and stochasticity of its parameters φ. We will later discuss invertibility of T . Here it is also critical to note that its invertibility is not equivalent with the invertibility of the function f it is based on; for an example, refer to the discussion in Section 2.2.

T는 x에서 샘플링 된 개별 이미지 X에 실제로 증가를 적용하는 함수 f (X; φ)와 다르다는 것을 이해하는 것이 중요합니다 (예 : 회전 증가의 경우 각도에 의해 일부 φ로 매개 변수화 됨). 분포의 모든 이미지에이 함수를 적용한 집계 효과를 캡처하고 함수 매개 변수의 무작위 화를 포함합니다. T는 함수 f의 비선형 성과 매개 변수 φ의 확률성에 관계없이 항상 선형적이고 결정적입니다. 나중에 T의 가역성에 대해 논의 할 것입니다. 여기에서 그것의 가역성은 그것이 기반으로하는 함수 f의 가역성과 동일하지 않다는 점에 유의하는 것이 중요합니다. 예를 들어 섹션 2.2의 설명을 참조하십시오.

Specifically, T is a (Markov) transition operator. Intuitively, it is an (uncountably) infinitedimensional generalization of a Markov transition matrix (i.e. a stochastic matrix), with nonnegative entries that sum to 1 along columns. In this analogy, probability distributions upon which T operates are vectors, with nonnegative entries summing to 1. More generally, the distributions have a vector space structure and they can be arbitrarily linearly combined (in which case they may lose their validity as probability distributions and are viewed as arbitrary signed measures). Similarly, we can do algebra with the with the operators by linearly combining and composing them like matrices. Concepts such as null space and invertibility carry over to this setting, with suitable technical care. In the following, we will be somewhat informal with the measure theoretical and functional analytic details of the problem, and draw upon this analogy as appropriate.

특히 T는 (Markov) 전환 연산자입니다. 직관적으로, 이것은 열을 따라 합이 1이되는 음이 아닌 항목을 가진 마르코프 전이 행렬 (즉, 확률 행렬)의 무한 차원 일반화입니다. 이 비유에서 T가 작동하는 확률 분포는 음이 아닌 항목의 합계가 1 인 벡터입니다.보다 일반적으로 분포는 벡터 공간 구조를 가지며 임의로 선형 결합 될 수 있습니다 (이 경우 확률 분포 및 임의의 서명 된 측정 값으로 간주 됨). 마찬가지로 연산자를 행렬처럼 선형 결합하고 구성하여 연산자를 사용하여 대수를 수행 할 수 있습니다. 널 공간 및 가역성과 같은 개념은 적절한 기술 관리와 함께이 설정으로 이어집니다. 다음에서, 우리는 문제의 이론적 및 기능적 분석 세부 사항에 대해 다소 비공식적이며 적절하게이 비유를 그릴 것입니다.

C.2 Invertibility implies non-leaking augmentations 가역성은 비누출 증가를 의미합

Within this framework, our question can be stated as follows. Given a target distribution y and an augmentation operator T , we train for a generated distribution x such that the augmented distributions match, namely

이 틀 안에서 우리의 질문은 다음과 같이 말할 수 있습니다. 목표 분포 y와 증가 연산자 T가 주어지면, 우리는 생성 된 분포 x에 대해 증가 된 분포가 일치하도록 훈련합니다.

T x = T y. (7)

The desired outcome is that this equation is satisfied only by the correct target distribution, namely x = y. We say that T leaks if there exist distributions x 6= y that satisfy the above equation, and the goal is to find conditions that guarantee the absence of leaks.

There are obviously no such leaks in classical non-augmented training, where T is the identity I, whence T x = T y ⇒ Ix = Iy ⇒ x = y. For arbitrary augmentations, the desired outcome x = y does always satisfy Eq. 7; however, if also other choices of x satisfy it, then it cannot be guaranteed that the training lands on the desired solution. A trivial example is an augmentation that maps every image to black (in other words, T z = δ0 for any z). Then, T x = T y does not imply that x = y, as indeed any choice of x produces the same set of black images that satisfies Eq. 7. In this case, it is vanishingly unlikely that the training finds the solution x = y.

원하는 결과는이 방정식이 올바른 목표 분포, 즉 x = y에 의해서만 충족된다는 것입니다. 위의 방정식을 만족하는 분포 x 6 = y가 존재하면 T가 누출된다고 말하며, 목표는 누출이 없음을 보장하는 조건을 찾는 것입니다. 고전적인 비 증강 훈련에는 분명히 그러한 누출이 없습니다. 여기서 T는 정체성 I이고, 여기서 T x = T y ⇒ Ix = Iy ⇒ x = y입니다. 임의의 증가의 경우 원하는 결과 x = y는 항상 Eq를 충족합니다. 7; 그러나 x의 다른 선택도 만족한다면 훈련이 원하는 솔루션에 도달한다고 보장 할 수 없습니다. 간단한 예는 모든 이미지를 검은 색으로 매핑하는 증강입니다 (즉, 모든 z에 대해 T z = δ0). 그러면 T x = T y는 x = y를 의미하지 않습니다. 실제로 x를 선택하면 Eq를 충족하는 동일한 검정 이미지 세트가 생성됩니다. 7.이 경우 훈련이 해 x = y를 찾을 가능성은 거의 없습니다.

More generally, assume that T has a non-trivial null space, namely there exists a signed measure n 6= 0 such that T n = 0, that is, n is in the null space of T . Equivalently, T is not invertible, because n cannot be recovered from T n. Then, x = y + αn for any α ∈ R satisfies Eq. 7. Therefore noninvertibility of T implies that measures in its null space may freely leak into the learned distribution (as long as the sum remains a valid probability distribution that assigns non-negative mass to all sets). Conversely, assume that some x 6= y satisfies Eq. 7. Then T (x − y) = T y − T y = 0, so x − y is in null space of T and therefore T is not invertible.

보다 일반적으로, T가 사소하지 않은 널 공간을 가지고 있다고 가정합니다. 즉, T n = 0, 즉 n이 T의 널 공간에있는 부호있는 측정 값 n 6 = 0이 존재합니다. 마찬가지로, n은 T n에서 복구 할 수 없기 때문에 T는 가역적이지 않습니다. 그러면 α ∈ R에 대한 x = y + αn은 Eq를 충족합니다. 7. 따라서 T의 비가역성은 null 공간의 측정 값이 학습 된 분포로 자유롭게 누출 될 수 있음을 의미합니다 (합이 모든 집합에 음이 아닌 질량을 할당하는 유효한 확률 분포로 유지되는 한). 반대로 일부 x 6 = y가 Eq를 충족한다고 가정합니다. 7. 그러면 T (x − y) = T y − T y = 0이므로 x − y는 T의 영 공간에 있으므로 T는 반전 할 수 없습니다.

Therefore, leaking augmentations imply non-invertibility of the augmentation operator, which conversely implies the central principle: if the augmentation operator T is invertible, it does not leak. Such a non-leaking operator further satisfies the requirements of Lemma 5.1. of Bora et al. [4], where the invertibility is shown to imply that a GAN learns the correct distribution.

따라서 누출 증가는 증가 연산자의 비가역성을 의미하며, 이는 반대로 중심 원칙을 의미합니다. 증가 연산자 T가 가역적이면 누출되지 않습니다. 이러한 비누출 연산자는 Lemma 5.1의 요구 사항을 추가로 충족합니다. of Bora et al. [4], 가역성은 GAN이 올바른 분포를 학습 함을 의미하는 것으로 표시됩니다.

The invertibility has an intuitive interpretation: the training process can implicitly “undo” the augmentations, as long as probability mass is merely shifted around and not squashed flat.

가역성에는 직관적 인 해석이 있습니다. 확률 질량이 평평하게 찌그러지지 않고 단순히 이동하는 한, 훈련 과정은 암시 적으로 증강을 "실행 취소"할 수 있습니다.

C.3 Compositions and mixtures

We only access the operator T indirectly: it is implemented as a procedure, rather than a matrix-like entity whose null space we could study directly (even if we know that such a thing exists in principle). Showing invertibility for an arbitrary procedure is likely to be impossible. Rather, we adopt a constructive approach, and build our augmentation pipeline from combinations of simple known-safe augmentations, in a way that can be shown to not leak. This calls for two components: a set of combination rules that preserve the non-leaking guarantee, and a set of elementary augmentations that have this property. In this subsection we address the former.

우리는 연산자 T에 간접적으로 만 접근합니다. 그것은 우리가 직접 연구 할 수있는 행렬과 같은 개체가 아니라 절차로 구현됩니다 (원칙적으로 그러한 것이 존재한다는 것을 알고 있더라도). 임의의 절차에 대해 가역성을 보여주는 것은 불가능할 수 있습니다. 오히려 우리는 건설적인 접근 방식을 채택하고, 누출되지 않는 것으로 보일 수있는 방식으로 알려진 안전하고 단순한 증강의 조합에서 증강 파이프 라인을 구축합니다. 이를 위해서는 두 가지 구성 요소가 필요합니다. 비누 출 보장을 유지하는 조합 규칙 집합과이 속성이있는 기본 확장 집합입니다. 이 하위 섹션에서는 전자를 다룹니다.

By elementary linear algebra: assume T and U are invertible. Then the composition T U is invertible, as is any finite chain of such compositions. Hence, sequential composition of non-leaking augmentations is non-leaking. We build our pipeline on this observation.

기본 선형 대수 : T와 U가 가역적이라고 가정합니다. 그런 다음 구성 T U는 그러한 구성의 유한 체인과 마찬가지로 가역적입니다. 따라서, 비누 출 증가의 순차적 구성은 비누 수입니다. 우리는이 관찰을 바탕으로 파이프 라인을 구축합니다.

The other obvious combination of augmentations is obtained by probabilistic mixtures: given invertible augmentations T and U, perform T with probability α and U with probability 1 − α. The operator corresponding to this augmentation is the “pointwise” convex blend αT + (1 − α)U. More generally, one can mix e.g. a continuous family of augmentations Tφ with weights given by a non-negative unit-sum function α(φ), as R α(φ)Tφ dφ. Unfortunately, stochastically choosing among a set of augmentations is not guaranteed to preserve the non-leaking property, and must be analyzed case by case (which is the content of the next subsection). To see this, consider an extremely simple discrete probability space with only two elements. The augmentation operator T = 0 1 1 0 flips the elements. Mixed with probability α = 1 2 with the identity augmentation I (which keeps the distribution unchanged), we obtain the augmentation 1 2 T + 1 2 I = 1 2 1 1 1 1 which is a singular matrix and therefore not invertible. Intuitively, this operator smears any probability distribution into a degenerate equidistribution, from which the original can no longer be recovered. Similar considerations carry over to arbitrarily complicated linear operators.

다른 명백한 증가 조합은 확률 적 혼합에 의해 얻어집니다. 가역적 증가 T와 U가 주어지면 확률 α로 T를 수행하고 확률 1 − α로 U를 수행합니다. 이 증가에 해당하는 연산자는 "점별"볼록 혼합 αT + (1 − α) U입니다. 더 일반적으로, 예를 들어 혼합 할 수 있습니다. R α (φ) Tφ dφ와 같이 음이 아닌 단위 합 함수 α (φ)에 의해 주어진 가중치를 갖는 연속 증가 군 Tφ. 안타깝게도 일련의 확장 중에서 확률 적으로 선택하는 것은 비누 출 속성을 보존한다고 보장 할 수 없으며 사례별로 분석해야합니다 (다음 하위 섹션의 내용). 이를 확인하기 위해 두 개의 요소 만있는 매우 단순한 이산 확률 공간을 고려하십시오. 증가 연산자 T = 0 1 1 0은 요소를 뒤집습니다. 확률 α = 1 2와 동일성 증가 I (분포를 변경하지 않은 상태로 유지)와 혼합하면 단일 행렬이므로 가역적이지 않은 증가 1 2 T + 1 2 I = 1 2 1 1 1 1을 얻습니다. 직관적으로이 연산자는 확률 분포를 퇴화 등분 포로 번져서 원본을 더 이상 복구 할 수 없습니다. 유사한 고려 사항이 임의로 복잡한 선형 연산자에도 적용됩니다.

C.4 Non-leaking elementary augmentations 비누출 기초 증강

In the following, we construct several examples of relatively large classes of elementary augmentations that do not leak and can therefore be used to form a chain of augmentations. Importantly, most of these classes are not inherently safe, as they are stochastic mixtures of even simpler augmentations, as discussed above. However, in many cases we can show that the degenerate situation only arises with specific choices of mixture distribution, which we can then avoid.

다음에서, 우리는 누출되지 않으므로 증강 체인을 형성하는 데 사용할 수있는 비교적 큰 클래스의 기본 증강의 몇 가지 예를 구성합니다. 중요한 것은, 이러한 클래스의 대부분은 위에서 논의한 것처럼 더 단순한 증가의 확률 적 혼합물이기 때문에 본질적으로 안전하지 않습니다. 그러나 많은 경우에 우리는 퇴화 상황이 혼합물 분포의 특정 선택에서만 발생한다는 것을 보여줄 수 있습니다.

Specifically, for every type of augmentation, we identify a configuration where applying it with probability strictly less than 1 results in an invertible transformation. From the standpoint of this analysis, we interpret this stochastic skipping as modifying the augmentation operator itself, in a way that boosts the probability of leaving the input unchanged and reduces the probability of other outcomes.

특히 모든 유형의 증강에 대해 엄격하게 1 미만의 확률로 적용하면 역변환이 발생하는 구성을 식별합니다. 이 분석의 관점에서, 우리는이 확률 적 건너 뛰기를 입력을 변경하지 않고 그대로 둘 가능성을 높이고 다른 결과의 가능성을 줄이는 방식으로 증가 연산자 자체를 수정하는 것으로 해석합니다.

C.4.1 Deterministic mappings 결정적 매핑

The simplest form of augmentation is a deterministic mapping, where the operator Tf assigns to every image X a unique image f(X). In the most general setting f is any measurable function and Tfx is the corresponding pushforward measure. When f is a diffeomorphism, Tf acts by the usual change of variables formula with a density correction by a Jacobian determinant. These mappings are invertible as long as f itself is invertible. Conversely, if f is not invertible, then neither is Tf .

가장 간단한 형태의 증강은 결정 론적 매핑으로, 연산자 Tf는 모든 이미지 X에 고유 한 이미지 f (X)를 할당합니다. 가장 일반적인 설정에서 f는 측정 가능한 함수이고 Tfx는 해당 푸시 포워드 측정입니다. f가 diffeomorphism이면 Tf는 Jacobian 행렬식에 의한 밀도 보정을 사용하여 변수 공식의 일반적인 변경에 따라 작동합니다. 이러한 매핑은 f 자체가 가역적이면 가역적입니다. 반대로 f가 가역적이지 않으면 Tf도 마찬가지입니다.

Here it may be instructive to highlight the difference between f and Tf . The former transforms the underlying space on which the probability distributions live – for example, if we are dealing with images of just two pixels (with continuous and unconstrained values), f is a nonlinear “warp” of the two-dimensional plane. In contrast, Tf operates on distributions defined on this space – think of a continuous 2-dimensional function (density) on the aforementioned plane. The action of Tf is to move the density around according to f, while compensating for thinning and concentration of the mass due to stretching. As long as f maps every distinct point to a distinct point, this warp can be reversed.

여기서 f와 Tf의 차이점을 강조하는 것이 도움이 될 수 있습니다. 전자는 확률 분포가 존재하는 기본 공간을 변환합니다. 예를 들어 단 2 픽셀의 이미지 (연속 및 제한되지 않은 값 포함)를 처리하는 경우 f는 2 차원 평면의 비선형 "왜곡"입니다. 반대로 Tf는이 공간에 정의 된 분포에서 작동합니다. 앞서 언급 한 평면에서 연속적인 2 차원 함수 (밀도)를 생각해보십시오. Tf의 작용은 f에 따라 밀도를 이동하는 동시에 스트레칭으로 인한 질량의 얇아 짐과 집중을 보상하는 것입니다. f가 모든 고유 지점을 고유 지점에 매핑하는 한이 뒤틀림은 반전 될 수 있습니다.

An important special case is that where f is a linear transformation of the space. Then the invertibility of Tf becomes a simpler question of the invertibility of a finite-dimensional matrix that represents f.

중요한 특별한 경우는 f가 공간의 선형 변환 인 경우입니다. 그러면 Tf의 가역성은 f를 나타내는 유한 차원 행렬의 가역성에 대한 더 간단한 질문이됩니다.

Note that when an invertible deterministic transformation is skipped probabilistically, the determinism is lost, and very specific choices of transformation could result in non-invertibility (see e.g. the example of flipping above). We only use deterministic mappings as building blocks of other augmentations, and never apply them in isolation with stochastic skipping.

가역적 결정 론적 변환을 확률 적으로 건너 뛰면 결정론이 손실되고 매우 특정한 변환 선택으로 인해 비가역성이 발생할 수 있습니다 (예 : 위의 뒤집기 예제 참조). 우리는 결정 론적 매핑을 다른 확장의 구성 요소로만 사용하고 확률 적 건너 뛰기와 격리하여 적용하지 않습니다.

C.4.2 Transformation group augmentations 변환 그룹 증가

Many commonly used augmentations are built from transformations that act as a group under sequential composition. Examples of this are flips, translations, rotations, scalings, shears, and many color and intensity transformations. We show that a stochastic mixture of transformations within a finitely generated abelian group is non-leaking as long as the mixture weights are chosen from a non-degenerate distribution.

일반적으로 사용되는 많은 증강은 순차적 구성에서 그룹 역할을하는 변환에서 작성됩니다. 이것의 예로는 뒤집기, 평행 이동, 회전, 크기 조절, 가위 및 다양한 색상 및 강도 변형이 있습니다. 유한하게 생성 된 아벨 그룹 내에서 확률 론적 변환 혼합은 혼합 가중치가 비 퇴화 분포에서 선택되는 한 누출되지 않음을 보여줍니다.

As an example, the four deterministic augmentations {R0, R90, R180, R270} that rotate the images to every one of the 90-degree increment orientations constitute a group. This is seen by checking that the set satisfies the axiomatic definition of a group. Specifically, the set is closed, as composing two of elements always results in an element of the same set, e.g. R270R180 = R90. It is also obviously associative, and has an identity element R0 = I. Finally, every element has an inverse, e.g. R −1 90 = R270. We can now simply speak of powers of the single generator element, whereby the four group elements are written as {R0 90, R1 90, R2 90, R3 90} and further (as well as negative) powers “wrap over” to the same elements. This group is isomorphic to Z4, the additive group of integers modulo 4.

예를 들어, 이미지를 90도 증분 방향으로 회전시키는 4 개의 결정 론적 증강 {R0, R90, R180, R270}이 그룹을 구성합니다. 이는 세트가 그룹의 공리적 정의를 충족하는지 확인하여 알 수 있습니다. 특히, 두 개의 요소를 구성하면 항상 동일한 세트의 요소가 생성되므로 세트가 닫힙니다. R270R180 = R90입니다. 또한 분명히 연관성이 있으며 동일 요소 R0 = I를 갖습니다. 마지막으로 모든 요소에는 역이 있습니다. R -1 90 = R270. 이제 단일 발전기 요소의 거듭 제곱에 대해 간단히 말할 수 있습니다. 그러면 4 개의 그룹 요소가 {R0 90, R1 90, R2 90, R3 90}로 작성되고 더 많은 (음수뿐 아니라) 거듭 제곱이 동일한 것에 "랩 오버"됩니다. 집단. 이 그룹은 모듈로 4 인 정수의 추가 그룹 인 Z4와 동형입니다.

A group of rotations is compact due to the wrap-over effect. An example of a non-compact group is that of translations (with non-periodic boundary conditions): compositions of translations are still translations, but one cannot wrap over. Furthermore, more than one generator element can be present (e.g. y-translation in addition to x-translation), but we require that these commute, i.e. the order of applying the transformations must not matter (in which case the group is called abelian).

랩 오버 효과로 인해 회전 그룹이 콤팩트합니다. 압축되지 않은 그룹의 예로는 번역 (비 주기적 경계 조건 포함)이 있습니다. 번역의 구성은 여전히 번역이지만 하나는 마무리 할 수 없습니다. 또한 생성기 요소가 두 개 이상있을 수 있지만 (예 : x- 변환에 추가하여 y- 변환), 이러한 통근이 필요합니다. 즉, 변환을 적용하는 순서는 중요하지 않아야합니다 (이 경우 그룹을 아벨이라고 함). .

Similar considerations extend to continuous Lie groups, e.g. that of rotations by any angle; here the generating element is replaced by an infinitesimal generator from the corresponding Lie algebra, and the discrete powers by the continuous exponential mapping. For example, continuous rotation transformations are isomorphic to the group SO(2), or U(1).